Arbeiten mit Google BigQuery: Wie Rohdaten die Webanalyse verändern

1. Digitale Analyse im Wandel

Mit der fortschreitenden Digitalisierung in Unternehmen gewinnt die zentralisierte Datenerhebung und Datenanalyse stetig an Bedeutung. Der Begriff “Data Driven“ wird immer mehr zur Leitkultur und somit fester Bestandteil der strategischen Unternehmensentwicklung. Ein grundlegendes Problem stellt jedoch die Verwendung zahlreicher Tools und Quellsysteme im Unternehmen dar. Daten befinden sich in Silos – es entstehen fragmentierte Nutzerprofile, welche sich schwer vereinheitlichen lassen. Hinzu kommt die Aggregierung der Daten sowie toolspezifische Definitionen von Kennzahlen. Das Resultat ist eine Abnahme der Datenqualität bei gleichzeitig steigenden Anforderungen an die Analyse. Zusätzlich sind Unternehmen häufig mit Personal- und Zeitkosten konfrontiert, sobald sie in fortgeschrittenere Analysen eintauchen wollen. Die Arbeit mit Rohdaten erfordert versiertere Fähigkeiten als ein grafisches Reporting Interface abverlangt. Um weiterhin wettbewerbsfähig zu sein, müssen Unternehmen datengetrieben arbeiten. Hierzu genügt es jedoch nicht, Daten aus allen Systemen zu zentralisieren und zu analysieren. Häufig scheitert es nicht an der Zentralisierung der Daten, sondern an der Gewinnung von Erkenntnissen aus der Analyse für die Ableitung zukünftiger Maßnahmen. Dies erfordert wiederum die Möglichkeit einer direkten Aktivierung der Daten in den einzelnen Tools und somit eine zentrale und standardisierte Datenbank.

Durch Plattformstrategien wie der Google Marketing Platform (GMP) und der Google Cloud Platform (GCP) werden die Eintrittsbarrieren in der Nutzung von Rohdaten systematisch aufgelockert. Aufgrund des breiten Spektrums an Product Linkings, APIs, integriertem Machine Learning und günstigem Hosting, wird das Arbeiten mit Rohdaten auch für kleine bis mittelständische Unternehmen deutlich einfacher und attraktiver. Mit der Einführung des BigQuery Streaming Exports in Google Analytics 4 (GA4) wurde erstmals auch Nutzern ohne Enterprise Lizenz (GA 360) die Nutzung von Google Analytics Rohdaten ermöglicht. Durch das Hosting der Rohdaten innerhalb der Google Cloud steht ein breites Spektrum an erweiterten Analyse- und Modellierungsfunktionen durch weitere Produkte der GCP zur Verfügung. Das Arbeiten mit Rohdaten in BigQuery birgt daher sehr viel Potenzial für die Marketing-Optimierung. App und Web Daten können nicht nur mit Daten aus anderen Systemen verbunden werden, sondern mittels bereitgestellter Algorithmen und komplexer Abfragen viel genauer und zielführender analysiert werden, als es ein Interface von Google Analytics ermöglichen könnte.

2. Rohdatenanalyse mit BigQuery

Das Arbeiten mit Rohdaten in BigQuery bietet eine Vielzahl von Vorteilen gegenüber einer klassischen Data Warehouse-Lösung. Warum sich BigQuery als Data Warehouse besonders gut eignet, welche Möglichkeiten für eine Daten-Infrastruktur bereitstehen und welche komplexen Use Cases sich unter anderem mit Rohdaten abbilden lassen, erfahren Sie in den folgenden Abschnitten.

2.1 Was ist eigentlich BigQuery?

Google BigQuery ist ein serverloses, hoch skalierbares Data Warehouse, das mit einer integrierten Abfrage-Engine ausgestattet ist. Die Abfrage-Engine ist in der Lage, SQL-Abfragen auf Terabytes von Daten in wenigen Sekunden und Petabytes in nur wenigen Minuten auszuführen. Diese Leistung kann dabei in Anspruch genommen werden, ohne eine Infrastruktur zu verwalten und ohne Indizes erstellen oder neu aufbauen zu müssen. BigQuery ist Bestandteil der Google Cloud Platform (GCP) und verfügt dadurch über ein ganzes Ökosystem an komplementären Diensten zur Weiterverarbeitung und Analyse der Rohdaten.

2.2 Eignung von BigQuery als Data Warehouse

Der grundlegende Gedanke bei dem Aufbau oder Umzug in ein cloudbasiertes Data Warehouse, wie BigQuery, ist die Trennung von Storage und Compute, wodurch sich beide Teile den Anforderungen entsprechend skalieren und kostengünstig betreiben lassen. Die erforderliche Speicher- und Rechenkapazität wird dadurch je nach benötigter Datenmenge automatisch festgelegt. Als integrativer Bestandteil der Google Cloud Platform (GCP) bringt die Nutzung von BigQuery jedoch eine Vielzahl weiterer Vorteile mit sich:

Flexible Datenanbindung

Der BigQuery Connector ermöglicht programmatischen Lese-/Schreibzugriff auf BigQuery. Dies ist eine ideale Methode, um in BigQuery gespeicherte Daten zu verarbeiten. Der Connector ist eine Bibliothek, mit der Spark- und Hadoop-Anwendungen Daten aus BigQuery verarbeiten und Daten mithilfe ihrer nativen Terminologie in BigQuery schreiben können. Hinzu kommt die vollständige Unterstützung von Standard und Legacy SQL, einschließlich der Unterstützung von Arrays und komplexen Joins. Insbesondere die Unterstützung für Arrays macht es möglich, hierarchische Daten (z. B. JSON-Datensätze) in BigQuery zu speichern, ohne dass die verschachtelten und sich wiederholenden Felder reduziert werden müssen.

Zudem bieten viele Produkte aus dem Google Universum als auch Third Party-Anbieter mittlerweile BigQuery Linkings und Connectoren an, wodurch eine einfache Anbindung der Daten möglich ist.

Flexible Preismodelle

Durch die bereits beschriebene Trennung von Storage und Compute bedarf es zur Nutzung von BigQuery keiner Bereitstellung einzelner Instanzen oder virtueller Maschinen. BigQuery weist Rechenressourcen automatisch nach Bedarf zu. Die Computing-Kapazität lässt sich ebenfalls in Form von Slots (virtueller CPUs) reservieren. Darüber hinaus bietet BigQuery kostenlose Vorgänge und eine kostenlose Nutzungsvariante. Die Preisstruktur von BigQuery spiegelt diese Flexibilität in ihren zwei Hauptkomponenten wider:

Analysepreise

Die Kosten für die Verarbeitung von Abfragen. Dazu gehören SQL-Abfragen, benutzerdefinierte Funktionen, Skripts sowie Anweisungen für bestimmte Datenbearbeitungssprachen (DML) und Datendefinitionssprachen zum Scannen von Tabellen.

Speicherpreise

Kosten für das Speichern von Daten in BigQuery. Bei BigQuery fallen für bestimmte Vorgänge wie das Streamen von Insert-Anweisungen und die Nutzung der BigQuery Storage API Kosten an.

Real (Near-)Time Funktionen

BigQuery bietet Realtime Data Streaming Funktionen an, die es erlauben, Daten innerhalb weniger Sekunden oder Minuten in BigQuery weiterzuverarbeiten. Mit Google Analytics 4 steht nun auch Basis-Nutzern die Möglichkeit eines Realtime Exports der Daten über den BigQuery Connector zur Verfügung.

Service Level Agreement (SLA)

Während der Laufzeit des geltenden Lizenzvertrags für Google BigQuery ist der Service betriebsbereit und für den Kunden verfügbar, wie im aktuellen SLA festgelegt. Weitere Informationen über das SLA finden Sie sich in der offiziellen Dokumentation von Google.

Machine Learning

Bisher war BigQuery darauf beschränkt, lediglich lineare Modelle für maschinelles Lernen zu erstellen und auszuführen. Seit Ende letzten Jahres wurden die Funktionen um die nicht linearen Modelltypen Boosted Trees für XGBoost, Deep Neural Networks (DNNs) für TensorFlow und AutoML Tables erweitert. Die mit BigQuery trainierten Modelle lassen sich zudem exportieren, um sie für Vorhersagen in der Google Cloud Vertex AI oder in vergleichbaren Umgebungen zu nutzen.

Datenverwaltung und -sicherheit

BigQuery ist so entwickelt, dass sich Nutzer darauf konzentrieren können, die Daten zu analysieren und Erkenntnisse zu gewinnen, ohne sich dabei grundlegende Gedanken um die technische Infrastruktur machen zu müssen, da der Speicher vollständig von dem Dienst verwaltet wird. Die Tatsache, dass grundlegend keine aufwändige Infrastruktur für das Datenmanagement eingerichtet werden muss, führt zu weniger Problemen in Bezug auf Sicherheit und Stabilität der Daten-Pipelines. Die Daten in BigQuery werden automatisch verschlüsselt, sowohl im Ruhezustand als auch bei der Übertragung. BigQuery kümmert sich um die Sicherheitsaspekte bei der Unterstützung mandantenfähiger Abfragen und der Isolierung zwischen Jobs. Datensätze können mit Google Cloud Identity and Access Management (IAM) freigegeben werden. Ebenso ist es möglich, die Datensätze und deren Tabellen und Ansichten so zu organisieren, dass sie verschiedenen Sicherheitsanforderungen entsprechen. In anderen Systemen nimmt die Bereitstellung der Infrastruktur für Zuverlässigkeit, Elastizität, Sicherheit und Leistung oft viel Zeit in Anspruch. Da sich diese administrativen Aufgaben mit der Nutzung von BigQuery minimieren lassen, bleibt mehr Zeit für die tatsächliche Analyse der Daten sowie der Gewinnung von Erkenntnissen.

2.3 Arbeiten mit Rohdaten in BigQuery

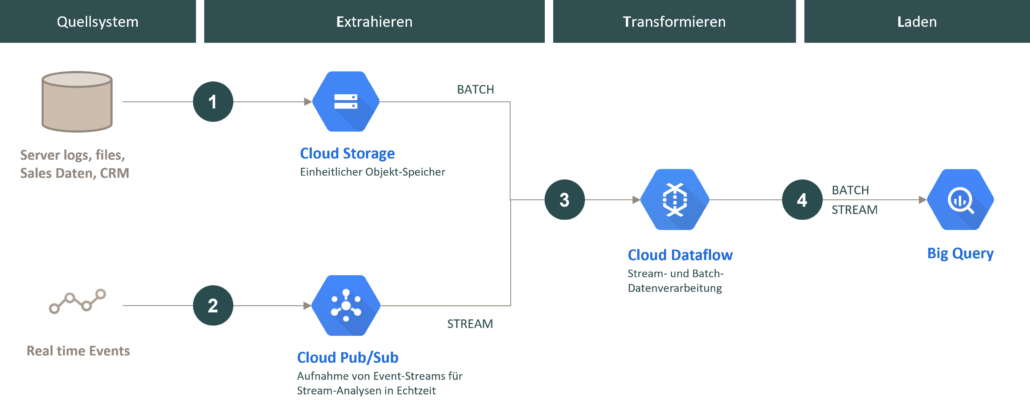

Die traditionelle Art, mit einem Data Warehouse zu arbeiten, beginnt mit einem ETL-Prozess (Extrahieren, Trans- formieren und Laden), bei dem Rohdaten aus ihrem Quellsystem extrahiert, transformiert und dann in das Data Warehouse geladen werden. BigQuery verfügt als cloud basierte Data Warehouse-Lösung über ein natives, hocheffizientes, spaltenförmiges Speicherformat, welches den klassischen ETL-Prozess zu einer attraktiven Methodik macht. Die Daten-Pipeline, die in der Regel über einen Connector mit Apache Beam oder Apache Spark geschrieben wird, extrahiert die erforderlichen Bits aus den Rohdaten (entweder Streaming-Daten oder Batch-Dateien), transformiert die extrahierten Daten, um alle erforderlichen Bereinigungen oder Aggregationen durchzuführen, und lädt sie dann in BigQuery. Das folgende Schaubild veranschaulicht eine klassische ETL-Pipeline mit der Nutzung von Google Cloud Services und BigQuery als Data Warehouse.

① Der Connector lädt die Batch-Daten vor oder während der Jobausführung in einen Cloud Storage-Bucket. Nachdem der Job erfolgreich abgeschlossen wurde, werden die Daten aus dem Cloud Storage gelöscht. Der Storage dient im ETL Prozess als einheitlicher Objekt-Speicher für Batch-Dateien diverser Quellsysteme.

② Der Dienst Cloud Pub/Sub fungiert als ansynchrone Messaging-Middleware von Realtime Data Streams. Dieser stellt Ressourcen für die Aufnahme, Verarbeitung und Analyse schwankender Echtzeit Datenmengen bereit und ermöglicht in Verbindung mit Cloud Dataflow und BigQuery eine Analyse und Auswertung der Daten in Echtzeit.

③ Die Batch- und Stream-Pipeline werden in Cloud Dataflow zusammengeführt. Cloud Dataflow ermöglicht Nutzern häufig verwendete Quelle-Ziel-Muster (source target patterns) mit Open Source-Vorlagen einfach einzurichten.

④ Anschließend werden die transformierten Daten über Cloud Dataflow in BigQuery geladen und stehen zur Analyse bereit.

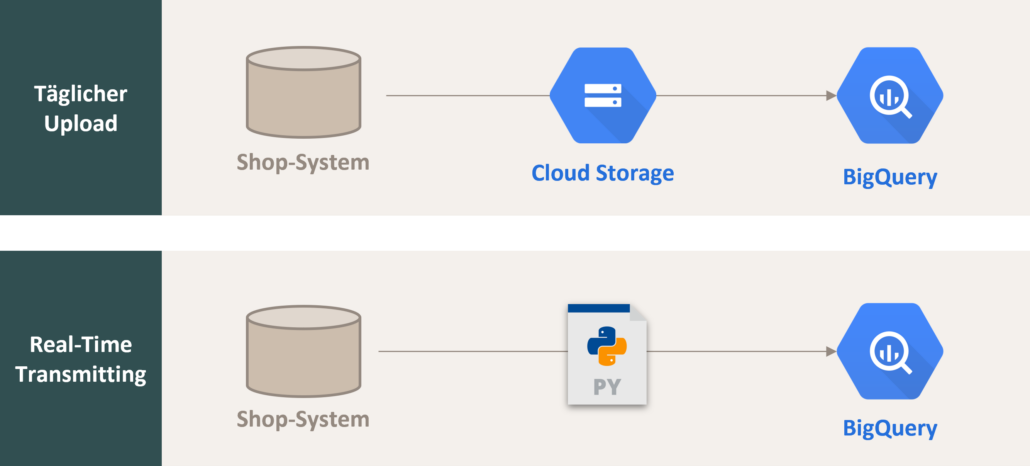

Auch wenn der Aufbau einer ETL-Pipeline mittels Apache Beam oder Apache Spark gängig ist, ist es dennoch möglich, eine Daten-Pipeline auch direkt in BigQuery zu integrieren. Da BigQuery die Berechnung und Speicherung trennt, ist es möglich, BigQuery SQL-Abfragen gegen CSV- (oder JSON- und Avro-) Dateien auszuführen, die in einem Google Cloud Storage gespeichert sind. Diese Fähigkeit wird als federated querying bezeichnet. Daten lassen sich so mithilfe von SQL-Abfragen gegen im Google Cloud Storage gespeicherte Daten extrahieren und transformieren, um dann die Ergebnisse in einer nativen BigQuery-Tabelle zu initialisieren. Das folgende Beispiel beschreibt einen in der Praxis gängigen EL-Prozess von E-Commerce Shop-Daten.

Über einen Google Cloud Storage lassen sich beispielsweise tagesaktuelle Shopdaten gegen einen Cloud Storage abfragen und in BigQuery in Form einer Tabelle analysieren. Eine andere Möglichkeit stellt das BigQuery Realtime Transmitting oder auch BigQuery Data Streaming dar. Hierbei können Daten aus einer externen Datenquelle transformiert und direkt an BigQuery geschickt werden (bspw. durch ein Python Script).

Wenn keine Transformation erforderlich ist, kann BigQuery Standardformate wie CSV, JSON oder Avro direkt in seinen nativen Speicher einlesen – ein EL-Workflow (Extract and Load), wenn man so will. Das anschließende Laden der Daten in den nativen Speicher von BigQuery bietet dabei die effizienteste Abfrageleistung.

Neben dem Aufbau einer klassischen Daten-Pipeline bietet BigQuery von Haus aus jedoch noch ein breiteres Spektrum an verfügbaren Services, die das Arbeiten mit Rohdaten in der Google Cloud attraktiver gestalten. Das folgende, vereinfachte Schaubild, gibt einen Überblick über das Potenzial in der Nutzung von BigQuery als zentrales Data Warehouse im digitalen Ökosystem.

Die direkte Konnektivität zu Produkten der Google Cloud oder der Google Marketing Platform als auch des BigQuery Data Transfer Service, wodurch sich Data Streams zu weiteren Google Produkten (Bsp. YouTube, Google Play Store etc.) oder Data Warehouse Systemen (Bsp. AWS) nutzen lassen, ergeben sich nahezu unbegrenzte Möglichkeiten in der Anreicherung und Weiterverarbeitung der Rohdaten. Zusätzlich können eine Vielzahl von Business Intelligence (BI)-Tools wie Tableau, Looker, Power BI und Google Data Studio verwendet werden, um aussagekräftige Analysen, Visualisierungen und Berichte über die in BigQuery enthaltenen Daten zu erstellen.

Großes Potenzial liegt ebenfalls in der Aktivierung der Rohdaten. Wie schon erwähnt, bietet BigQuery eine direkte Konnektivität zu weiteren Services der Google Cloud Platform an. Somit lassen sich die Daten durch integriertes Machine Learning beispielsweise für Vorhersagen und Personalisierung einsetzen.

2.4 Advanced Analytics mit BigQuery (Use Case)

Dass sich BigQuery durch einen hohen Grad an Konnektivität sowie Komplementarität zu einer Vielzahl von Produkten und Services auszeichnet und sich somit besonders gut für die Weiterverarbeitung von Rohdaten und komplexere Analysen eignet, wurde bereits umfassend dargestellt. Um ein besseres Verständnis für die praktische Umsetzung zu bekommen, werden im Folgenden drei Use Cases aus der Praxis vorgestellt.

2.4.1 Recommendation Engines

Recommendation Engines (RE) stellen die Technologie hinter Vorschlagsfunktionen von E-Commerce Websites dar. Eine Recommendation Engine verbessert die User Experience, indem sie den Nutzern relevante Artikel oder Inhalte zur richtigen Zeit und auf der richtigen Seite anbietet. Angesichts der fortschreitenden Verlagerung der Customer Journey, insbesondere im Einzelhandel, ist die Gewährleistung eines hochgradig personalisierten Einkaufserlebnisses für Online-Nutzer von entscheidender Bedeutung für die weitere Kundenbindung. Recommendation Engines helfen Kunden dabei, Produkte zu entdecken, die ihren Vorstellungen und Bedürfnissen entsprechen, indem sie bereits gekaufte Produkte ergänzen oder ähnliche Kaufprofile anderer Nutzer vorschlagen.

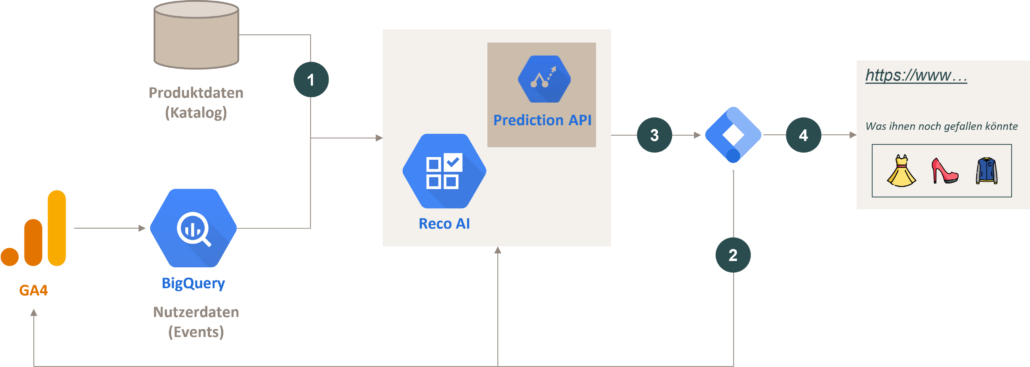

Durch die Nutzung von BigQuery in Verbindung mit weiteren GCP Services lässt sich ohne großen technischen Aufwand in wenigen Schritten eine Recommendation Engine für einen Onlineshop einrichten. Die Einrichtung einer Recommendation Engine mithilfe von GA4, BigQuery und der Recommendations AI (Reco AI), als Google Cloud Service, wird in diesem Schaubild veranschaulicht.

① Zuerst werden die Produktdaten in Form eines Produktkataloges in die Reco AI eingelesen, damit diese später als Datengrundlage für dynamische Empfehlungen verwendet werden können.

② Über den auf der Website implementierten GTM-Container werden Produkt-Interaktionen des Nutzers erfasst und direkt an GA4 übermittelt. Dabei wird das im dataLayer ausgesteuerte Ecommerce-Object zusätzlich über ein spezielles Tag im GTM an die Reco AI übermittelt.

③ Die Prediction API wählt anhand der vorgenommenen Einstellungen in der Reco AI (Auswahl des Empfehlungsmodells, Optimierungsziel etc.) und der Datengrundlage des spezifischen Nutzers Produktempfehlungen aus dem Produktkatalog aus und überliefert das Ergebnis an den Google Tag Manager.

④ Über den Google Tag Manager werden die Daten nun in den auf der Seiten integrierten Container ausgeliefert und dem Nutzer während seiner Sitzung dynamisch anhand aktueller Informationen angezeigt.

2.4.2 Realtime Marketing Attribution

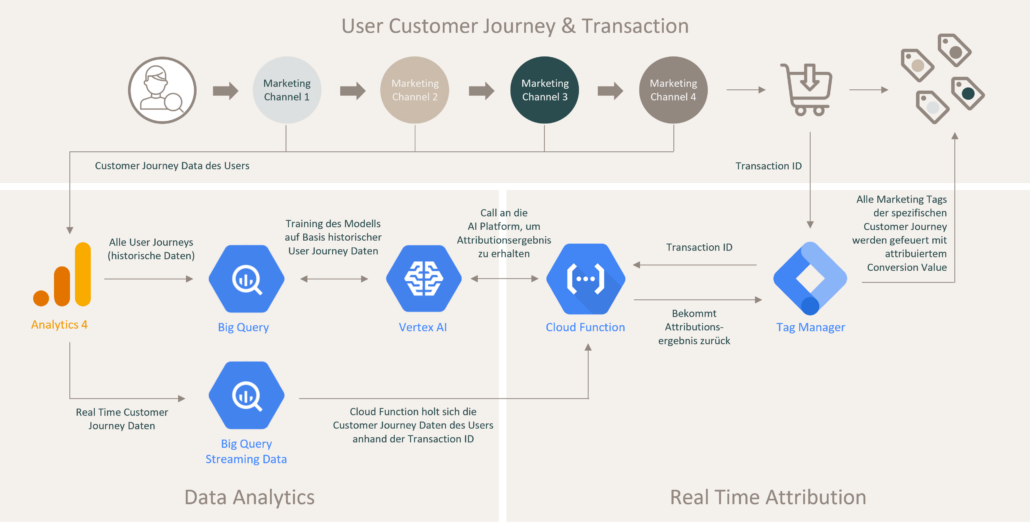

Bevor es zum Kauf (Conversion) kommt, bewegt sich der Kunde in den meisten Fällen über mehrere Marketingkanäle hinweg. Marketingaktivitäten sollten daher auf Grundlage der ganzen Customer Journey betrachten werden, um dessen Effektivität ganzheitlich beurteilen zu können. Diese Erkenntnisse können dann genutzt werden, um das Marketing-Budget besser zwischen den einzelnen Marketingkanälen (Cross-Channel) zu verteilen. Leider findet die Optimierung innerhalb der Marketingkanäle (Intra-Channel) nicht Kanalübergreifend (Cross-Channel) statt. Die Optimierung innerhalb einzelner Marketingkanäle findet deshalb nicht auf der gleichen Datengrundlage statt, was zu Fehlentscheidungen führt. Realtime Marketing Attribution kann dabei genau dieses Problem lösen.

Mit GA4 und dem BigQuery Realtime Export steht erstmals ein praxistauglicher Ansatz für eine ganzheitliche Bewertung der Marketing Kanäle zur Verfügung. Hierbei wird bei jedem Kaufabschluss der Conversion Value basierend auf einem Attributionsmodell anhand der gesamten Customer Journey (Cross-Channel) berechnet. Dieser Wert wird wiederum an alle Marketing Tools übergeben und kann dort innerhalb der einzelnen Tools (Intra-Channel) für operative Optimierungen genutzt werden.

Ein detaillierter Einblick in die technische Umsetzung wird im exklusiven mohrstade Whitepaper Realtime Marketing Attribution vorgestellt.

2.4.3 Google Ads Automatisierung (Bsp. Dynamische Sitelinks)

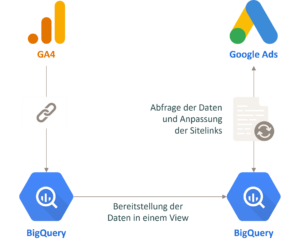

Mithilfe des BigQuery Exports in GA4 lassen sich diverse Abläufe für Google Ads automatisieren. Ein praxistaugliches Beispiel wäre die automatische Anpassung von Sitelinks in Google Ads Anzeigen. Hierbei soll das verkaufsstärkste Produkt der letzten 120 Tage mit Preis und passender Verlinkung dynamisch eingefügt werden. Verdeutlicht wird dies im folgenden Schaubild:

Ein detaillierter Einblick in die technische Einrichtung und Umsetzung findet sich in unserem zugehörigen MarTechSnack:

MarTechSnack #8 | Google Ads Automatisierung mit GA4 BigQuery Daten.

3. Empfehlung

Das Arbeiten mit Rohdaten mit BigQuery birgt sehr viel Marketing Optimierungspotenzial. App und Web Daten können nicht nur mit Daten aus anderen Systemen verbunden werden, sondern mittels bereitgestellter Algorithmen und komplexer Abfragen viel genauer und zielführender analysiert werden, als das Google Analytics Interface ermöglicht. Zudem bietet das Arbeiten innerhalb der Cloud Umgebung viele Möglichkeiten, die aus der Analyse gewonnene Ergebnisse und Erkenntnisse anderen Tools zur Verfügung zu stellen.

Es sollte sich also nicht die Frage gestellt werden, warum man langfristig auf eine Nutzung der Rohdatenanalyse durch BigQuery zurückgreifen sollte, sondern warum nicht. Der Funktionsumfang und die daraus resultierenden Möglichkeiten für Optimierungspotenziale steigen rasant. Jedes Unternehmen sollte deshalb jetzt anfangen, sich mit dem Thema Rohdaten auseinandersetzen, um intern eine Expertise aufzubauen.