Warum Measurement Tools ausgedient haben

Spätestens seit Bekanntgabe des Sunsets von Universal Analytics sehen sich viele Enterprise-Unternehmen mit der Mammut-Aufgabe konfrontiert, ihr bisheriges komplexes und historisch gewachsenes Tracking Setup in die Logik eines neuen Datenmodells zu übertragen. Auch die schwierige datenschutzrechtliche Situation, in der sich Measurement Tools wie Google Analytics 4 im europäischen Raum derzeit befinden, bereitet vielen Nutzern Kopfzerbrechen. Die Kontrolle über den Prozess der Datenerhebung und die Unabhängigkeit von tool-spezifischen Schemata werden für viele Unternehmen daher immer relevanter. Doch auch aus strategischer Sicht ist ein Tool wie Google Analytics 4 oder Adobe Analytics für den Einsatz im Enterprise-Unternehmen nicht geeignet und sollte nicht die Funktion eines zentralen Analysetools für die Beantwortung geschäftskritischer Fragestellungen einnehmen.

In diesem Blogbeitrag wird anhand der Entwicklung zweier Branchengrößen in der Digitalen Analyse auf die aktuelle Rolle von Measurement Tools und die aus ihr resultierende Problematik im Enterprise-Unternehmen eingegangen. Anschließend zeigt ein tool-agnostischer Lösungsansatz auf, wie sich relevante Quellsysteme zentral in der Cloud zusammenführen und analysieren lassen.

1. Entwicklung von Adobe und Google in der Digitalen Analyse

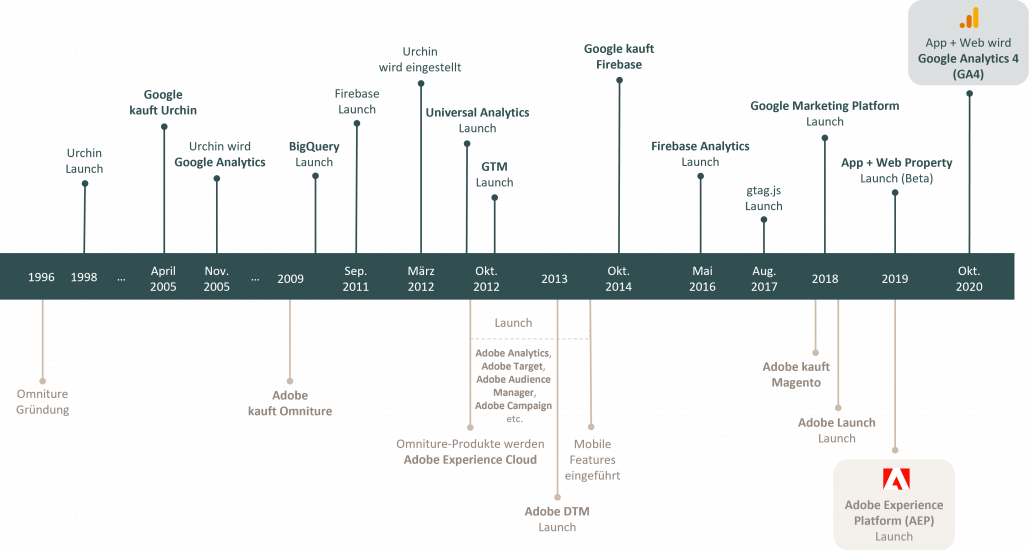

Abbildung 1: Entwicklung der Digitalen Analyse im Zeitverlauf (Adobe und Google)

Die Übernahme der Firma Urchin legte die technologische Grundlage für die Entstehung von Google Analytics im November 2005. Knapp vier Jahre später akquirierte Adobe mit der Firma Omniture eine eigene Onlinemarketing- und Web-Analytics-Unit und trat mit Omniture SiteCatalyst, Vorgänger des heutigen Adobe Analytics, in den Wettbewerb zu Google Analytics.

Nach knapp einem Jahrzehnt Weiterentwicklung der Plattform sowie dem Launch des Google Tag Managers gegen Ende des Jahres 2012, gab Google die Übernahme der App-Analytics- und Development-Software Firebase bekannt. In der Zwischenzeit hatte Adobe die Adobe Marketing Cloud, heute Adobe Experience Cloud (AEC), gelauncht, in der die ehemaligen Omniture-Produkte unter einem Rebranding neu eingeführt und weiterentwickelt worden waren. Adobe Analytics war geboren und mit ihm bekannte Tools wie Adobe Target, Adobe Audience Manager und Adobe Campaign. 2013 launchte Adobe mit dem Dynamic Tag Management (DTM) das erste Tag-Management-System.

Im Jahr 2018 vereinte Google mit dem Launch der Google Marketing Platform (GMP) alle Google-Dienste rund um Werbung, WebAnalyse und Personalisierung auf einer Plattform. Dies sollte eine zentrale und übergreifende Erfassung aller Daten ermöglichen, die wiederum für die Optimierung und Aussteuerung von Kampagnen überdasGoogle-Werbenetzwerknötigwar.Zeitgleichveröffentlichte Adobe unter Adobe Launch ein neues Tag-Management-System.

Adobe Analytics war jedoch Universal Analytics in seinen Analysefunktionen weit überlegen. Auf der anderen Seite wurde der Google Tag Manager von vielen Experten dem Tag Management von Adobe vorgezogen.

Mit der Einführung von Google Analytics App + Web im Jahr 2019 ging Google einen neuen Weg. Mit Firebase im Produktportfolio, der steigenden Relevanz des mobilen Einkaufserlebnisses und der zunehmenden Nutzung von Apps legte Google die technologische Weiterentwicklung des bis dato 15 Jahre alten Universal Analytics auf Eis. Zu diesem Zeitpunkt wurde die Attribution digitaler Kontaktpunkte in der Customer Journey zusätzlich durch Datenschutzrichtlinien wie DSGVO und ePrivacy erschwert. Das auf Firebase basierende Datenmodell sollte die Customer Journey zwischen Web und App verbessern und eine moderne technologische Grundlage nach einem event-basierten Datenschema mit Machine-Learning-Funktionalitäten bieten. Auch die Analysefunktionen sollten die aus Adobe Analytics übertreffen. Das eigene Analysetool „Explore“ ermöglichte viele wichtige WebAnalyse-Anforderungen, wie z. B. Funnel-Analysen. Relativ zeitgleich ging Adobe mit dem Release der Adobe Experience Platform (AEP) einen anderen Weg und legte mit einer neuen Infrastruktur den Fokus auf datengetriebene Enterprise-Unternehmen.

Mit der AEP schuf Adobe eine zentrale Schnittstelle, auf der alle unternehmensrelevanten Daten nach einem standardisierten Event-Schema zusammengeführt und modelliert werden können. Nachgelagerte Tools der Suit profitieren von einer einheitlichen Datengrundlage. Google isoliert Google Analytics mit Google Analytics 4 (GA4) weiterhin von der performanten Infrastruktur sowie den Services der Google Cloud und beschränkt die Analyse verhaltensbasierter Webdaten somit standardmäßig auf das Analysetool.

Welche Problematik aus dieser Entwicklung resultiert, soll im folgenden Kapitel deutlich werden, in dem zunächst die aktuelle Rolle der beiden Measurement Tools Adobe Analytics und GA4 im zugehörigen Cloud-Ökosystem dargestellt, die Schwierigkeiten für den Endnutzer aufgezeigt und schließlich ein tool-agnostischer Lösungsansatz präsentiert wird.

1.1 Die aktuelle Rolle von Measurement Tools wie Adobe Analytics und GA4

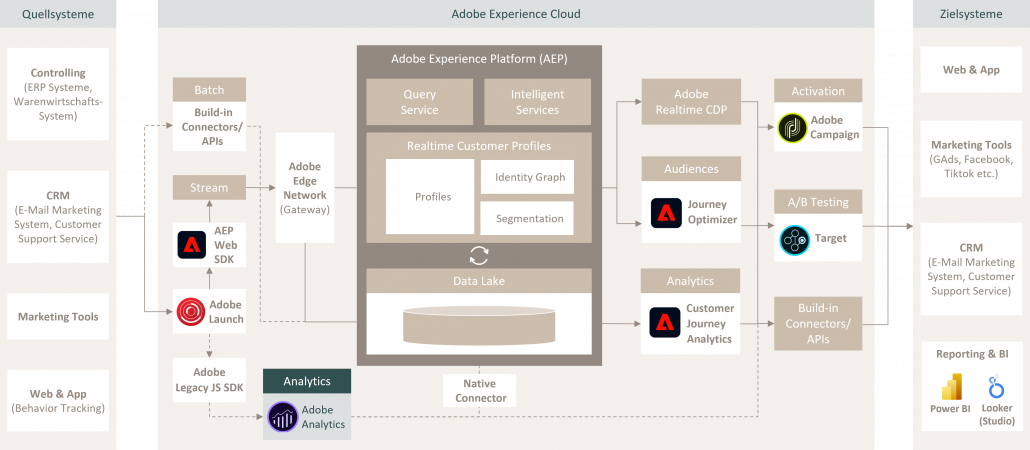

Abbildung 2: Data Analytics Pipeline im Cloud-Ökosystem der AEC und AEP

Mit der Einführung des AEP Web SDK schaffte es Adobe, auch die Erfassung verhaltensbasierter Webdaten über das Edge Network in ein einheitliches Datenschema zu standardisieren und sie in der Adobe Experience Platform (AEP) als zentrale Schnittstelle für die weitere Datenverarbeitung und Aktivierung in Tools und in den Zielsystemen verfügbar zu machen. Nachgelagerte Tools und Systeme wie bspw. Customer Journey Analytics, Journey Optimizer oder die Realtime Customer Data Platform (CDP) profitieren von der Zentralisierung der Webdaten und der Erstellung der Realtime Visitor Profiles aus der Orchestrierung der Profilfragmente angebundener Quellsysteme. Daten aus Adobe Analyticslassen sich über einen nativen Konnektor in die AEP laden. Adobe Analytics selbst kann jedoch nicht auf die Daten aus der AEP für die Analyse zurückgreifen.

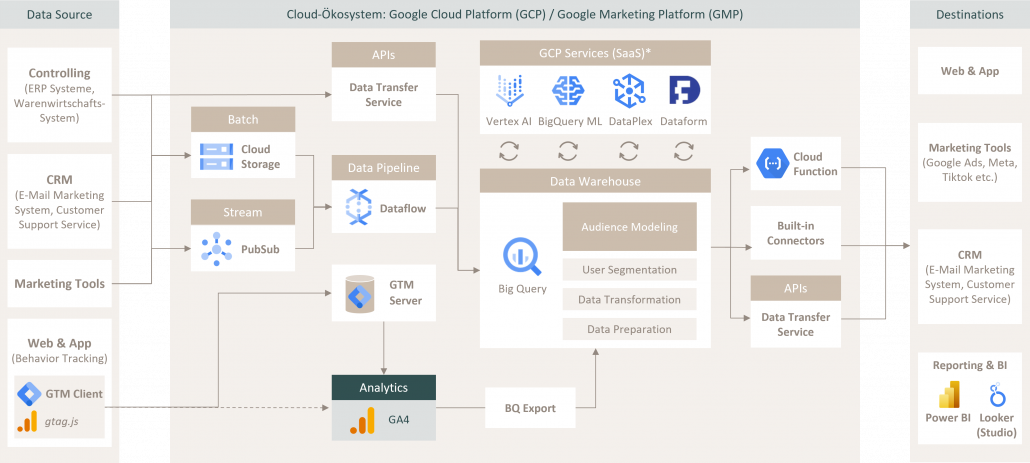

Abbildung 3: Data Analytics Pipeline im Cloud-Ökosystem der GMP und GCP (1)

Als Teil der Google Marketing Platform (GMP) lassen sich die Rohdaten aus Google Analytics 4 (GA4) bei Bedarf mittels nativem Konnektor zu BigQuery, einem Cloud Data Warehouse, übertragen und für die weitere Datenverarbeitung nutzen. Die Google Cloud Platform (GCP) bietet zudem zahlreiche Services und Möglichkeiten, um Daten aus unterschiedlichen Quellsystemen zu BigQuery zu überführen. Zwar läuft die GMP mit ihren Produkten technologisch auf der Infrastruktur der GCP, doch ist sie aus tooltechnischer Perspektive losgelöst von den Produkten und Services der GCP. Daten aus GMP-Produkten wie GA4 müssen zuerst zu BigQuery innerhalb der GCP übertragen werden, bevor sie für die Weiterverarbeitung genutzt werden können. Als Analysetool kann GA4 somit nicht direkt auf die Infrastruktur der GCP mit ihren Services für die Analyse und Modellierung der Daten zugreifen. Das gilt auch für Adobe Analytics im Hinblick auf die AEP. Aus diesem historisch gewachsenen Konstrukt ergeben sich daher für beide Tools gewisse Probleme, die eine zentrale Datenverarbeitung und Datenanalyse in der Cloud erschweren bzw. unmöglich machen.

1.2 Die daraus resultierende Problematik

Die Adobe Experience Platform (AEP) fungiert als zentrale Schnittstelle in der Adobe Experience Cloud (AEC) und schafft mit dem Edge Network ein standardisiertes Event-Schema für die neuen Tools von Adobe. Adobe Analytics profitiert allerdings nicht von diesen Daten und ist nur noch ein Anhängsel im Schatten der AEP und ihrer Tool-Suit. Auch Google Analytics 4 (GA4) ist als Produkt der Google Marketing Platform (GMP) grundlegend vom Ökosystem der Google Cloud und ihren Services isoliert. Zuvor in GA4 aggregierte Daten lassen sich über den BigQuery Export zu BigQuery zwar übermitteln, jedoch baut GA4 als Tool nicht direkt auf den exportierten Rohdaten in BigQuery auf, sodass keine weiteren Daten aus relevanten Quellsystemen zu BigQuery hinzugefügt und anschließend mit GA4 analysiert werden können. Als zentrales Data Warehouse bietet BigQuery demnach den optimalen Einstiegspunkt für die Datenanalyse, Modellierung und Zusammenführung aller unternehmensrelevanten Daten.

Im Vergleich bietet Adobe Analytics ein breites Spektrum an Analysefunktionen und Individualisierbarkeit. Die Nutzung des Tools hingegen ist mit Kosten verbunden und kann darum mit dem Marktanteil von GA4 als free-to-use Measurement Tool nicht konkurrieren. Mit einem einheitlichen Datenschema und der Zentralisierung der Daten innerhalb der AEP verfolgt Adobe einen zeitgemäßen Ansatz, wobei die Kosten für die Nutzung der Plattform für kleine bis mittelständische Unternehmen nicht stemmbar sind.

Mit GA4 versucht Google ebenfalls, ein performantes Reportingund Analysetool zu entwickeln. Doch schon mit Universal Analytics hat Google mittels zahlreicher Anbindungen an Tools und Schnittstellen für Kostendaten- und Daten-Uploads den Versuch unternommen, ein zentrales Tool für die Digitale Analyse im Unternehmen einzuführen, und ist gescheitert. Auch mit der strategischen Positionierung von GA4 als Analysetool innerhalb der Google Cloud ist diese Bemühung kläglich gescheitert. Entsprechend ergeben sich grundlegende Kritikpunkte, die das meistgenutzte Measurement Tool (1) für den Einsatz in einem Enterprise-Unternehmen ungeeignet machen. Die Punkte werden in einer Übersicht auf der folgenden Seite näher beschrieben.

1 Vgl. W3Techs | Web Technology Surveys: Market share trends for traffic analysis tools, abgerufen von https://w3techs.com/technologies/history_overview/traffic_analysis am 20.04.2023

“GA4 ist eine Fehlkonstruktion und verkommt zu einem reinen Monitoring Tool, das für Analysen im Enterprise-Unternehmen nicht ausreicht. Langfristig kann das Tool daher nur ein Zwischenschritt zu einem holistischen Analysewerkzeug sein.”

Zitat: Patrick Mohr

Kritikpunkte zur Nutzung von GA4

1. Eingeschränkte Individualisierung

Die Standard Reports in GA4 eignen sich zwar für einen schnellen Überblick über relevante Metriken, doch ist die Individualisierbarkeit durch Filtermöglichkeiten sehr eingeschränkt. Die mit GA4 eingeführten Exploration Reports bieten einen höheren Grad an Individualisierbarkeit als die Standard Reports, aber wenig Möglichkeiten für die Modellierung der Daten. Beispielsweise bleibt die Date Range eines erstellten Exploration Reportsstatisch und kann nicht geändert werden. Für die Änderung des Zeitraums muss zunächst eine Kopie des Reports erstellt werden.

2. Einschränkungen im Datenschutz

Bei der Verwendung einer client-seitigen Integration des gtag.js werden die erfassten Nutzerdaten (z. B. User Agent, IP-Adresse) ohne weitere Kontrolle über die Datenverarbeitung direkt an die ServerEndpunkte von Google Analyticsin dieUSA gesendet. Allgemein geltende Datenschutzanforderungen der DSGVO und des TTDSG werden in diesem Zusammenhang im Standardbetrieb des Tools nicht erfüllt. Funktionen zur Data Governance, wie sie bspw. Dataplex in der Google Cloud automatisiert, werden durch das Tool nicht geboten.

3. Isolierte Daten und fehlende Datenintegration

Die eigentliche Rechenleistung für die Analyse und Datenmodellierung der Google Cloud innerhalb BigQuery bleibt GA4 verwehrt, da das Tool keine Daten aus der Google Cloud (sprich BigQuery)selbst beziehen kann. In GA4 verarbeitete und analysierte Daten stehen nur in der Form zur Verfügung, wie sie durch das gtag.js erfasst wurden. Wie auch Universal Analytics bietet GA4 zusätzlich einige Datenintegrationen wie bspw. Kostendaten-Uploads, um externe Daten anzureichern. Allerdings ist die Zusammenführung verschiedener Datenquellen nicht zielführend, da Daten ebenso direkt in BigQuery zusammengeführt werden können, ohne einen Umweg über den GA4 BigQuery Export zu machen. Die Möglichkeit der externen Datenintegration ist demnach kein Schritt in Richtung Zentralisierung, sondern eher eine Reaktion auf den Wettbewerb und die Anforderungen von Kunden und Unternehmen.

4. Tool-spezifisches Datenschema

In GA4 gibt es zwar die Möglichkeit, Data Streams zu konfigurieren, jedoch muss sich in der Konfiguration der Data Collection einem starren Event-Format gebeugt werden. Nutzer sind also abhängig von Änderungen am Datenmodell und eingeschränkt in der Erhebung und Modellierung der Daten. Zudem findet ein Preprocessing der Daten statt, wodurch in GA4 selbst keine Rohdaten zur Verfügung stehen. Das gilt ebenso für Adobe Analytics, da die AEP das XDMSchema verwendet und die Data Collection über das Edge Network validiert wird. Auch wenn die AEP Daten aus unterschiedlichen Datenquellen zentralisiert und das XDM-Schema viel Spielraum zur Individualisierung bietet, ist es dennoch auf die Nutzung innerhalb der AEP beschränkt.

5. Blackbox Attribution

GA4 stellt eine Blackbox in der Attribution dar, da das Attributionsmodell technisch nicht einsehbar ist und auch nicht auf die individuellen Besonderheiten des Geschäftsmodells abgestimmt werden kann. Insbesondere bei langen Sales Cycles oder einer komplexeren Customer Journey wird die Attribution schwierig, da GA4 nur über eingeschränkte Daten verfügt. Jedes System tendiert dazu, sich selbst einen höheren Wertbeitrag an der Conversion zuzuschreiben und diese für sich zu beanspruchen. In GA4 werden verschiedene Attributions-Logiken einem Schema (Cross Channel) unterzogen, wodurch einige Conversions nicht korrekt ausgewiesen werden. Im Data Warehouse können die Attribution und Channel-Attribution flexibel geändert und individuell angepasst werden

2. Tool-agnostischer Lösungsansatz (am Beispiel der Google Cloud)

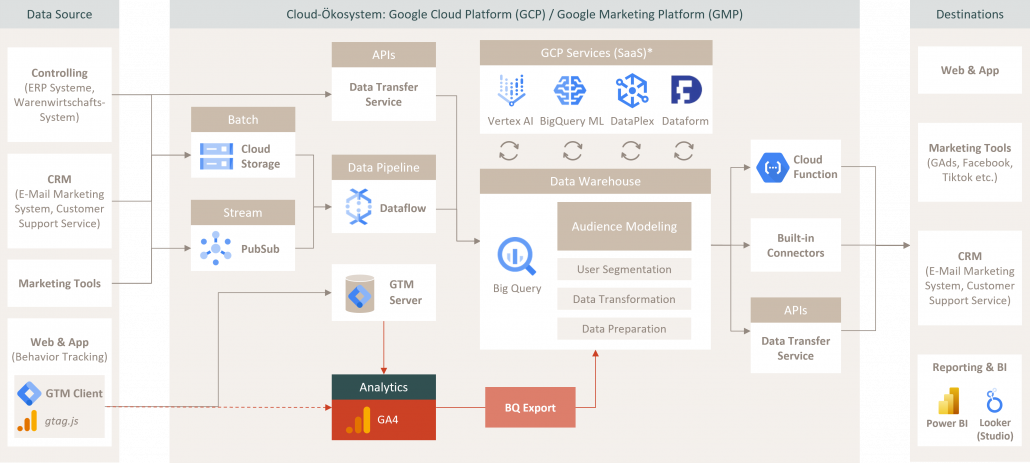

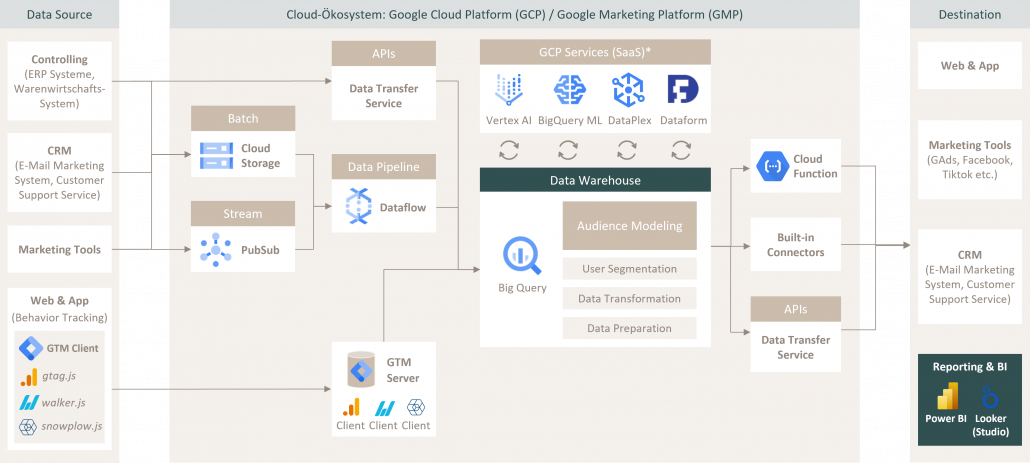

Abbildung 4: Data Analytics Pipeline im Cloud-Ökosystem der GMP und GCP (2)

Aus der Sicht eines Enterprise-Unternehmens stellt sich die Frage, wie sich unternehmensrelevante Datenquellen zentralisiert zusammenführen, modellieren und analysieren lassen. Beworben als zentrales Analysetool versagt Google Analytics 4 (GA4) aufgrund seiner strategischen Positionierung im Cloud-Ökosystem der Google Cloud Platform (GCP) allerdings im Hinblick auf diese Anforderungen. Die Analyse und der Export der GA4-Daten zu BigQuery ist ein unnötiger Zwischenschritt auf dem Weg zu einer zentralisierten Datenerfassung. Daher empfiehlt es sich, die Analyse der Daten direkt in BigQuery vorzunehmen und die verhaltensbasierten Webdaten mit zusätzlichen NutzerInformationen aus CRM-Systemen oder Marketingtools in einem unabhängigen tool-agnostischen Format anzureichern.

Abbildung 5: Data Analytics Pipeline im Cloud-Ökosystem der GMP und GCP (3)

Für die client-seitige Erfassung verhaltensbasierter Daten haben sich in den letzten Jahren mehrere Anbieter auf dem Markt etabliert, die sich auf den Prozess der Data Collection spezialisiert haben. Zu nennen sind Dienste wie der walker.js von Elbwalker oder Snowplow, die den Aufbau einer individualisierbaren toolagnostischen Data Analytics Pipeline ermöglichen. Snowplow bietet mit der Iglu-Technologie ein eigenes Schema-Design. Dieses setzt Rahmenbedingungen für die Event-Qualität, anhand derer einlaufende Event-Hits validiert werden. Es erfolgt somit ein gegenseitiger Abgleich zwischen Iglu-Server und Tracking Framework zur Gewährleistung einer maximalen Datenqualität. Über einen Google-Tag-Manager-Server werden die Daten anschließend zu BigQuery im Rohdatenformat übermittelt.

In BigQuery zusammengeführt, stehen anschließend Services wie die Vertex AI oder BigQuery ML für das Audience Modeling aus den Nutzerdaten aller relevanten Datenquellen zur Verfügung. Die Analyse der Daten in Reporting- und BI-Tools wie Looker Studio und Power BI beruht auf einer einheitlichen Datengrundlage, wovon auch nachgelagerte Tools für die Marketing-Aktivierung profitieren.

3. Empfehlung

Mit Tools wie GA4 wird versucht, eine “One size fits all”-Lösung für die Digitale Analyse auf dem Markt zu etablieren. Um einen schnellen Überblick zu Standardmetriken sowie Website- und Kampagnen-Performance zu erhalten, reicht das Tool aus. Für die Beantwortung komplexer analytischer Fragestellungen eignet sich das Tool jedoch nicht. Auch die Isolation der Daten von anderen unternehmensrelevanten Datenquellen in einem tool-spezifischen Format macht das Tool für die Nutzung im Enterprise-Unternehmen unattraktiv. Der Aufbau einer tool-agnostischen Data Pipeline mit anschließender Zentralisierung der Daten in einem Cloud Data Warehouse stellt die optimale Alternative dar, um eine einheitliche Datengrundlage für die Aktivierung und Analyse der Daten zu schaffen. Anbieter wie Adobe gehen mit der Adobe Experience Platform (AEP) einen zeitgemäßen und zukunftssicheren Weg, indem über ein einheitliches Datenschema eine Zentralisierung der Daten auf einer Plattform stattfinden kann.