Inhalt

- Wichtige Updates für den GA4 Audience Builder

- Checkout Report in GA4 verfügbar

- Erneute Erhöhung der GA4 API Limits

- Integration von Looker in die Google Cloud Console

- Neue Features in Dataform

- Klonen und Sortieren von Tabellen in BigQuery

- Recommender für Partitionierung und Clustering in BigQuery

- Neuer Identifier für Google Ads Kampagnen

- Response Header in Chrome überschreiben

- Launch der Chrome Attribution Reporting API

- Preview der Microsoft Fabrics Analytics Platform

- mohrstade Whitepaper | Digitale Analyse mit der Piwik Pro Analytics Suite

Liebe Leser,

so kurz vor dem Sunset von Universal Analytics richten sich natürlich alle Augen auf GA4 und welche neuen Features noch vor dem Abschalten von Universal Analytics integriert werden. In dieser Ausgabe unseres MarTechBriefings ist die Liste neuer oder aktualisierter GA4 Features sehr lang, dennoch fällt es schwer, von Feature-Parität zu sprechen. Zudem gibt es Neuerungen in Google Ads und Google Chrome, die für Marketers sehr spannend sein dürften.

Viel Spaß beim Lesen!

1. Wichtige Updates für den GA4 Audience Builder

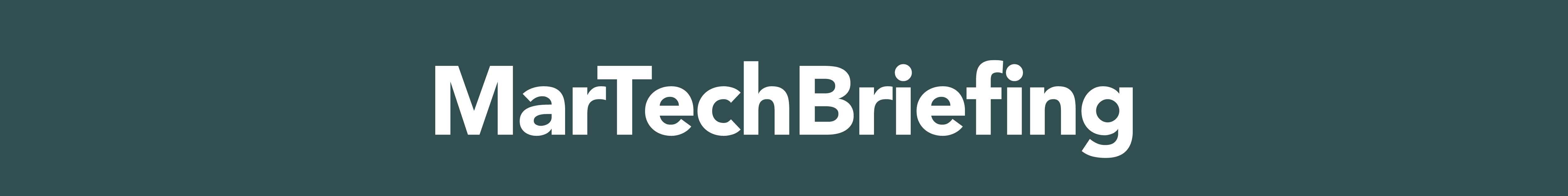

Mitte des Monats gab es ein umfangreiches Updates für den Audience Builder in GA4. Das Update stellt neue Dimensionen und Metriken im Audience Builder zur Verfügung. Der Großteil sind Item-scoped Dimensionen und Metriken aus dem E-Commerce. Zusätzlich wurde eine Auswahl neuer Operatoren für die Definition von Bedingungen für Events ergänzt und mit „Low engagement sessions“ sogar eine neue Metrik für das Tool eingeführt.

Item-scoped (E-Commerce) Dimensionen und Metriken

Nun steht auch die vollständige Anzahl aller bekannten Item-scoped Dimensionen des E-Commerce Trackings im Audience Builder zur Verfügung. Genutzt werden für die Bildung von Audience können somit u.a. die Item ID, Item affiliation, Item brand, Item category, Item list name und viele Weitere.

Low engagement sessions

Mit der Metrik „Low engagement sessions“ lassen sich Nutzer segmentieren, die wenig Engagement (Interaktionen) während vergangener Sitzungen aufgezeigt haben. Diese lassen sich somit mit gezielten Kampagnen ansprechen oder aber auch von Marketingmaßnahmen ausschließen.

Neue Operatoren

Die Anzahl an Operatoren in der Event Count Metrik wurde durch die Operatoren „Größer gleich oder gleich (>=)“, „Weniger als oder gleich (<=)“ ergänzt. Zuvor waren nur die Werte größer (>), kleiner (<) und gleich (=) verfügbar, und dies auch nur bei der Auswahl des „jüngsten Zeitraums“.

Quelle: analytics.google.com

2. Checkout Report in GA4 verfügbar

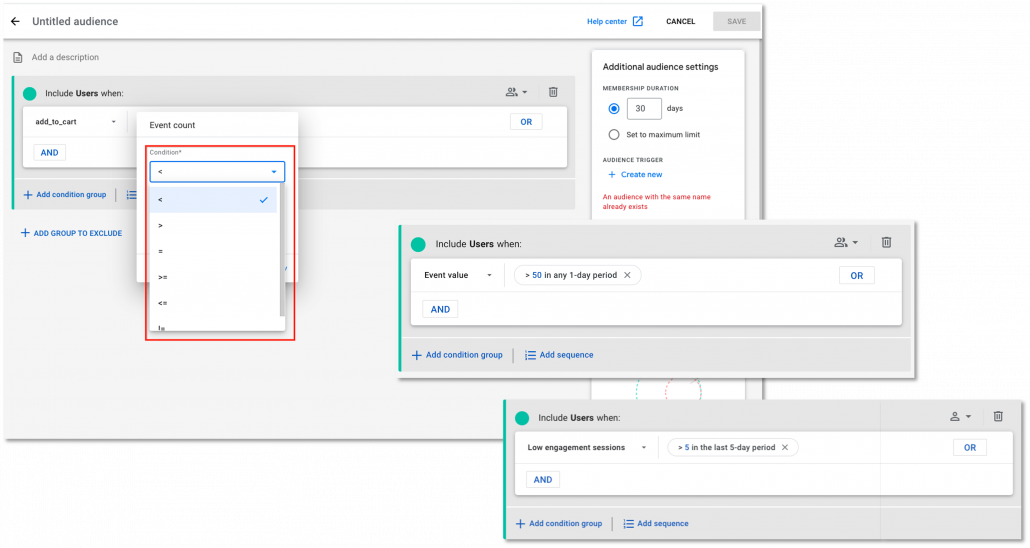

Der Universal Analytics Sunset steht kurz vor der Tür. An GA4 wird weiter auf Hochtouren gearbeitet. Im Mai wurden wir deshalb mit dem aus Universal Analytics bekannten Funnel Report als auch der Möglichkeit zur Erstellung eines Custom Funnel Report überrascht, auf den über das Exploration Tab im User Interface zugegriffen werden kann.

Der Report „Kaufprozess“ ist unter dem Reiter „Monetarisierung“ der Standard Reports zu finden. Dieser zeigt das Engagement der Nutzer über den gesamten Kaufprozess und stellt die Absprungraten zwischen den einzelnen Schritten bis zum Kaufabschluss dar. Unterhalb des Shopping Funnels wird die Anzahl der Nutzer nach Gerätekategorie in tabellarischer Form dargestellt. Die Gerätekategorie lässt sich jedoch durch weitere Primär-Dimensionen wie z. B. Browser, Sprache, Region und Land austauschen.

Über den Exploration Tab lässt sich der Funnel Report über ein bereitgestelltes Template individualisieren oder für maximale Flexibilität von Grund auf neu erstellen und anschließend der „Collection“ in den Standard Reports hinzufügen.

Quelle: analytics.google.com

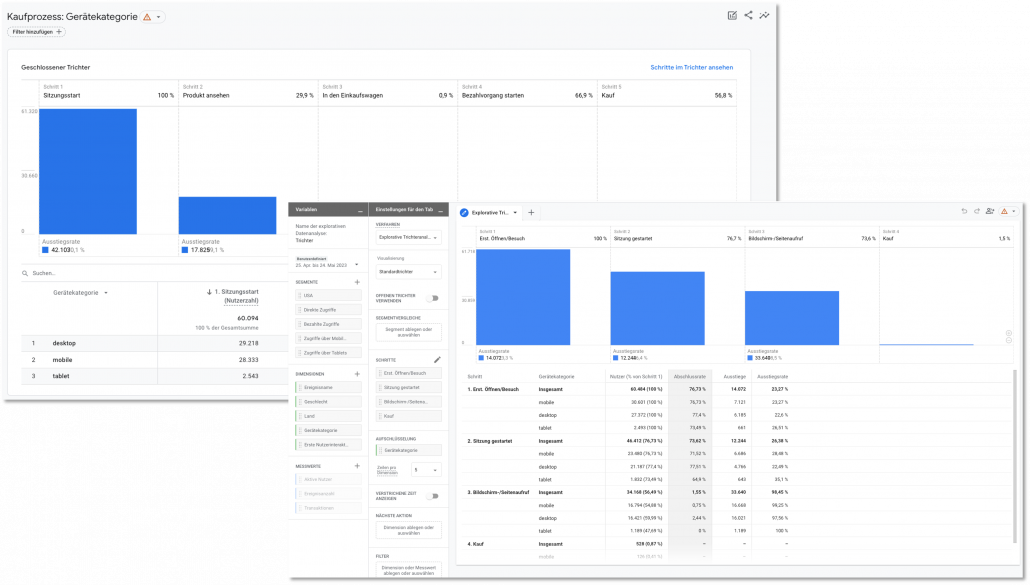

3. Erneute Erhöhung der GA4 API Limits

Schon seit Monaten hallt Unmut aus der GA4 Community über die bestehenden GA4 Data API Limits für die Nutzung in Looker Studio. Nach einer ersten Korrektur der Limits im März wurden diese nun erneut angehoben. Dieses Mal zur Freude aller Nutzer mit einer beachtlichen Erhöhung!

Erhöht wurden die Request Limits für die Haupttokens, Realtime Tokens und Funnel Tokens pro Projekt, Property und Stunde um 175.000 für Standard-Properties und um 1.750.000 für Analytics-360-Properties.

Jede Abfrage verbraucht Kontingente für Tokens pro Property pro Stunde und Tokens pro Projekt und Property pro Stunde. Das bedeutet, dass mehr als vier Projekte auf eine Property zugreifen müssen, bevor das Kontingent „Tokens pro Property pro Stunde“ vor dem Kontingent „Tokens pro Projekt und Property pro Stunde“ aufgebraucht sein kann.

Quelle: support.google.com

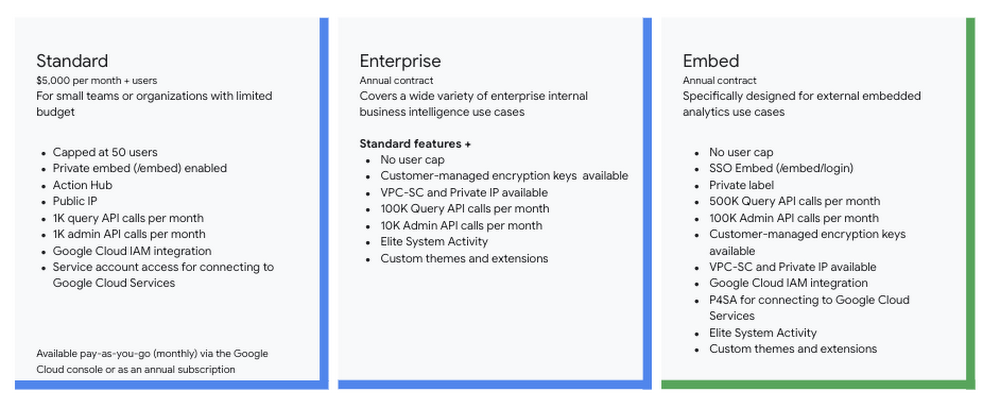

4. Integration von Looker in die Google Cloud Console

Mit dem Service „Looker (Google Cloud core) Embed“ wird Looker nun auch ein integrativer Bestandteil der Google Cloud und lässt sich somit direkt über die Google Cloud Console nutzen.

Looker (Google Cloud core) Embed lässt sich dabei in Anwendungen, Produkte oder Portale einbetten. Zusätzlich zu allen in der Looker Enterprise Edition enthaltenen Funktionen bietet Looker (Google Cloud core) Embed 500.000 Query-API-Aufrufe pro Monat und 100.000 Admin-API-Aufrufe pro Monat, SSO Embed und Private-Label-Funktionen.

Quelle: cloud.google.com

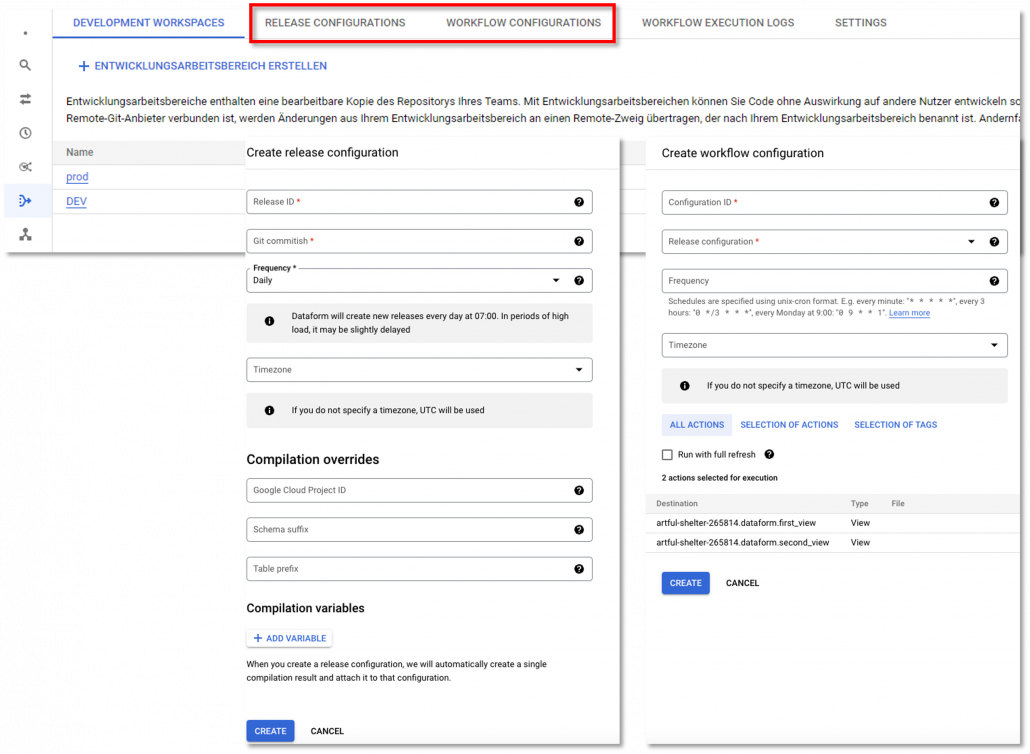

5. Neue Features in Dataform

Nach langer Zeit hat Dataform nun den Status einer Preview abgelegt und ist generell verfügbar (GA). Zusätzlich wurde das Tool um zwei weitere Konfigurationsmöglichkeiten für Releases und Workflows ergänzt.

Release Configurations

Um SQL-Workflows in BigQuery auszuführen, kompiliert Dataform den Code des SQL-Workflows in einem Compilationsergebnis. Mit der neuen Funktion Release Configurations kann dieses Kompilierungsergebnis jetzt angepasst werden, um Ausführungsumgebungen wie bspw. eine Stage zu erstellen. Das aktuellste Kompilierungsergebnis, das für die Release-Konfiguration erstellt wurde, wird dabei als Live-Compilationsergebnis gehandhabt.

Workflow Configurations

In Workflow Configurations können Dataform Workflows oder auch SQL-Workflows in BigQuery geplant werden. Hierzu wird die vorab erstellte Release Configurations für das Kompilierungsergebnis ausgewählt und anschließend Aktionen sowie Ausführungszeitplan für die Ausführung des Workflows festgelegt.

Quelle: cloud.google.com

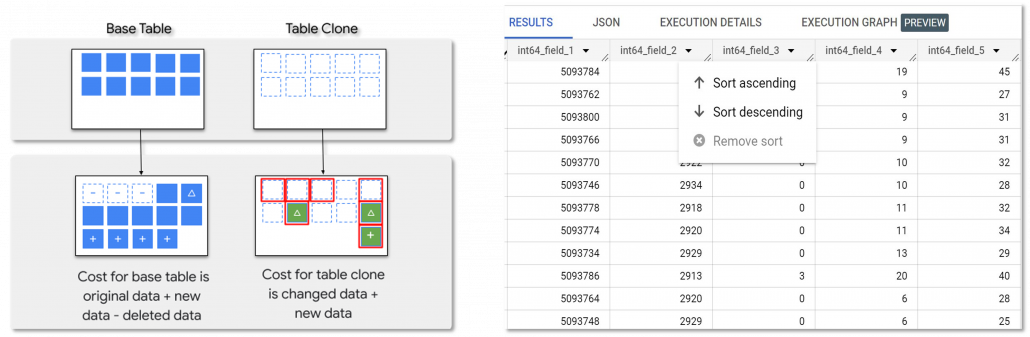

6. Klonen und Sortieren von Tabellen in BigQuery

Im Mai gab es auch für BigQuery neue Features. Darunter existiert nun die Möglichkeit, Klone von Tabellen zu erstellen. Für das Klonen einer Tabelle werden lediglich Kosten für die Speicherung von Daten im Tabellenklon in Rechnung gestellt, wenn diese sich von den Daten in der Basistabelle unterscheiden. Für Tabellenklone fallen anfangs also keine Speicherkosten an. Abgesehen vom Abrechnungsmodell für den Speicher und einigen zusätzlichen Metadaten für die Basistabelle ähnelt ein Tabellenklon in seinen Funktionen einer Standardtabelle. Nachdem ein Tabellenklon erstellt wurde, ist dieser von der Basistabelle unabhängig. Für Tabellenklone gelten die gleichen Kontingente und Limits wie für Standardtabellen.

Zusätzlich lassen sich Daten innerhalb einer Tabelle jetzt nachträglich sortieren. Hierbei sollte jedoch beachtet werden, dass das Sortieren der Daten ebenfalls Rechenleistung in Anspruch nimmt und somit mit Kosten verbunden ist.

Quelle: cloud.google.com

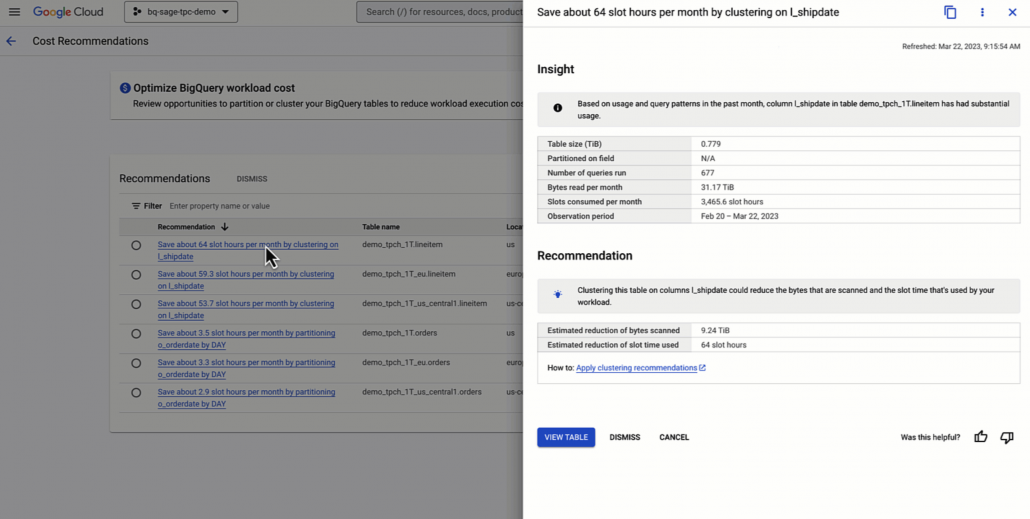

7. Recommender für Partitionierung und Clustering in BigQuery

Seit dem 31. Mai stellt BigQuery einen kostenlosen Recommender Service für die Partitionierung und das Clustering von Tabellen bereit. Der Recommender analysiert alle Workloads und Tabellen der vergangenen 30 Tagen innerhalb eines Projektes, um anschließend eine Empfehlung zu potenziellen Einsparungen zu generieren. Der Prozess umfasst dabei die vier Hauptschritte Candidate Generation, Read Pattern Analyzer, Write Pattern Analyzer und Generate Recommendations:

Candidate Generation

Für die Partitionierung werden Tabellen ausgewählt, die größer als 100 GB sind. Für das Clustering werden Tabellen berücksichtigt, die 10 GB überschreiten. Der Grund für das Herausfiltern der kleineren Tabellen ist laut Google, dass der Nutzung für die Optimierung geringer und weniger vorhersehbar sei. Anschließend werden Spalten ermittelt, die den Partitionierungs- und Clustering-Anforderungen von BigQuery entsprechen.

Read Pattern Analyzer

Im nächsten Schritt erfolgt eine Analyse der Query-Protokolle, um das Potenzial für Kosteneinsparungen durch Partitionierung oder Clustering zu ermitteln. Es werden u.a. mehrere Metriken, wie Filterselektivität, potenzielles Data Pruning und die Runtime berücksichtigt.

Write Pattern Analyzer

Der Write Pattern Analyzer führt nun eine Einschätzung der Kosten durch, die durch Partitionierung oder Clustering entstehen können. Hierfür werden Schreibmuster und Tabellenschema werden analysiert, um die Nettoeinsparungen durch Partitionierung oder Clustering für jede Spalte zu ermitteln.

Generate Recommendations

Im letzten Schritt wird die Ausgabe des Read Pattern Analyzers und des Write Pattern Analyzers verwendet, um die Nettoeinsparungen durch Partitionierung oder Clustering für jede Spalte zu ermitteln. Wenn die Nettoeinsparungen positiv und aussagekräftig sind, werden die Empfehlungen mit den entsprechenden IAM-Berechtigungen in die Recommender API hochgeladen.

Quelle: cloud.google.com

8. Neuer Identifier für Google Ads Kampagnen

Aus alt mach neu? Google nutzt seit kurzem für die Identifizierung von Ad-Clicks auf Google Ads Kampagnen einen neuen URL-Parameter. Der gad Parameter soll den altbekannten gclid Parameter ablösen und wird zurzeit sukzessiv ausgerollt.

Offizielle Informationen zu Googles Beweggründen für die Ablöse des gclid Parameters gibt es nicht. Es lässt jedoch vermuten, dass Google mit der Einführung einer neuen Kennzeichnung von Kampagnen Tracking-Blocker und Anti-Tracking-Frameworks wie das ATT von Apple umgehen möchte, die standardmäßig den gclid Parameter blockieren. Es ist jedoch nur eine Frage der Zeit, bis auch dieser Parameter auf die Blacklist der Anbieter gelangt.

Quelle: support.google.com

9. Response Header in Chrome überschreiben

Mit der Einführung der Version 113 des Chrome-Browser besteht nun die Möglichkeit, den Response Header eines Http-Request über das Network Panel der Developer Tools zu überschreiben oder einen neuen Header hinzuzufügen.

Bisher war für diese Aktionen ein direkter Zugriff auf den Webserver nötig. Mit dem Überschreiben von Response Header über das Network Panel können ab sofort lokal Korrekturen für folgende Header vorgenommen werden:

Cross-Origin Resource Sharing (CORS)

Cross-Origin Resource Sharing (CORS) ist ein auf HTTP-Header basierender Mechanismus, der es einem Server ermöglicht, andere Ursprünge (Domain, Schema oder Port) als den eigenen anzugeben, von denen der Browser das Laden von Ressourcen erlauben soll. Wenn eine Webseite auf Ressourcen einer anderen Domain zugreifen möchte, sendet der Browser einen HTTP-Request, der zusätzliche CORS-Header enthält. Die Zielseite prüft diese Header und entscheidet dann, ob Zugriff gewährt wird. Dadurch wird eine kontrollierte und sichere Kommunikation zwischen verschiedenen Domains ermöglicht.

Permissions-Policy Header

Der HTTP Permissions-Policy-Header bietet einen Mechanismus, um die Verwendung von Browser-Funktionen in einem Dokument oder innerhalb von <iframe> Elementen im Dokument zuzulassen oder zu verweigern.

Cross-Origin Isolation Headers

Die Isolation-Header Cross-Origin-Embedder-Policy (COEP) und Cross-Origin-Opener-Policy (CORP) dienen dazu, die Sicherheit und Kontrolle über eingebettete Ressourcen und Navigation in Cross-Origin-Szenarien zu verbessern. Der COEP-Header ermöglicht es, die Art und Weise zu kontrollieren, wie Webseiten als <iframe> in andere Websites eingebettet werden. Über CORP-Header kann die Steuerung des geöffneten Fensters oder Tabs bei der Navigation auf einer Website kontrolliert werden. Bestimmte Funktionen können somit beschränkt werden, um potenzielle Sicherheitsrisiken zu minimieren und die Kontrolle über die Interaktion des Embeds auf anderen Seiten zu gewährleisten.

Quelle: support.google.com

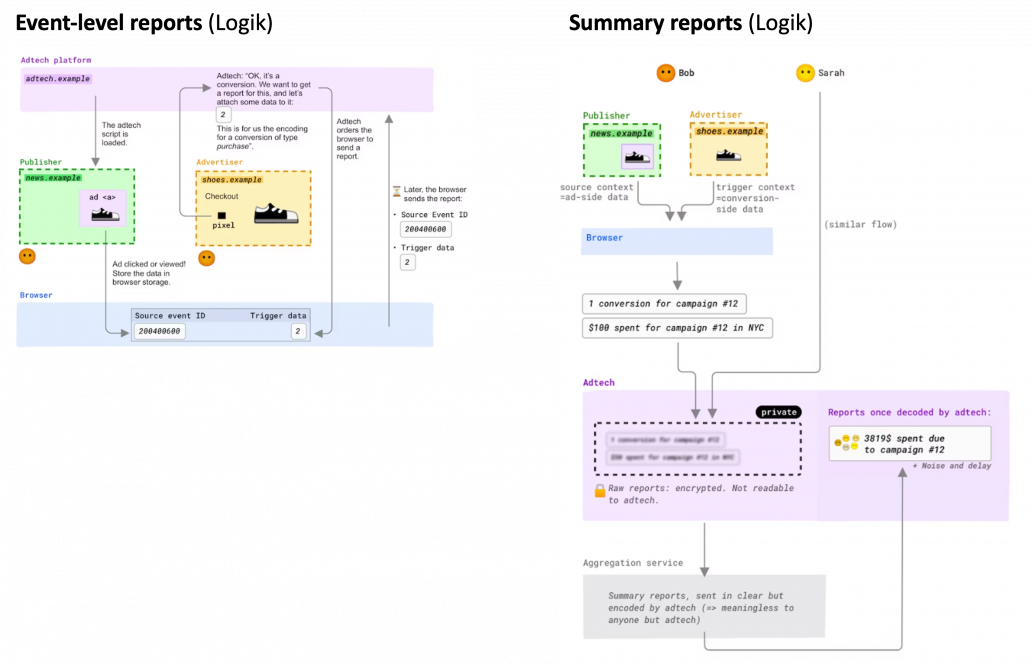

10. Launch der Chrome Attribution Reporting API

Die Attribution Reporting API ist ebenfalls ein Teil der Privacy Sandbox APIs und konzentriert sich auf die Messung relevanter Conversion-Metriken und ihrer Attribution. In Anbetracht des geplanten Phase-out von Third-Party Cookies Mitte 2024 hat Google nun geplant, die API mit ihren Funktionalitäten noch bis Mitte des Jahres auszurollen. Zurzeit wird die Attribution Reporting API noch von einer kleinen Gruppe, der Web Incubator Community Group, getestet. Laut Google soll ein zeitnaher globaler Zugang zur API jedoch dabei helfen, die von der API abgedeckten Use Cases und Funktionen zu validieren. So schreibt Google selbst:

“The use cases served by the Attribution Reporting API are important to effectively support the needs of the ecosystem before phasing out third-party cookies.”

Die Attribution Reporting API bietet dabei zwei verschiedene Arten von Reportings, die an Drittanbieter für die Conversion Attribution gesendet werden können:

Event-level reports

Stellt einen Bezug zwischen einer Ad Impression oder eines Klicks (Drittanbieter) mit einem Conversion Event auf der Website her. Der Browser gleicht Impressions und Klicks mit den vom Drittanbieter definierten Konversiondaten ab. Zeitverzögert sendet der Browser anschließend die Reports an einen vordefinierten Endpunkt.

Summary reports

Im Gegensatz zu den Event-level reports sind diese nicht an ein spezifisches Event auf der Seite des Drittanbieters gebunden und bieten demnach detaillierte Informationen über die Website Conversion. Wenn ein Nutzer auf eine Anzeige klickt, zeichnet der Browser das Event zusammen mit der vorher festgelegten Attributionskonfiguration auf. Sobald der Nutzer konvertiert, gleicht der Browser dieses detaillierte Klick- oder Impression Event (attribution source event) mit den detaillierten Konversionsdaten (attribution trigger data) ab. Anschließend gibt der Browser die Daten in einem aggregierten Report über die API aus.

Detailliertere Informationen zu der Attribution Reporting API und ihrem technischen Aufbau finden Sie hier.

Quelle: developers.chrome.com

11. Preview der Microsoft Fabrics Analytics Platform

Ende des Monats hat Microsoft eine erste Preview seiner Analytics Platform namens Microsoft Fabrics veröffentlicht. Die Plattform soll bestehende Data-Produkte der Azure Cloud in einer ganzheitlichen End-to-End Lösung integrieren. Daten werden in einem agnostischen Datenformat in die Platform geladen, das von allen Produkten genutzt werden kann. Eingehende Workloads werden dabei automatisch mit OneLake, einem Data Lake, verknüpft. Ungefähr so, wie alle Microsoft 365-Anwendungen mit OneDrive verknüpft sind. Über Shortcuts können Daten somit mit einzelnen Nutzern und Produkten geteilt werden, ohne diese zu duplizieren. Zudem wird der Transfer der Daten aus der Azure Cloud zu Amazon S3 und Google Storage (in Kürze), ermöglicht. Microsoft Fabric bietet standardmäßig Workflows zu folgenden Produkte der Azure Cloud:

Data Factory (Preview):

Ein ETL Management-Dienst für die serverlose Datenintegration und Datentransformation von Workflows und Data Pipelines innerhalb der Azure Data Cloud. Standardmäßig werden 150 Konnektoren zu Cloud-Diensten und lokalen Datenquellen geboten, die über ein eigenes User Interface per Drag-and-Drop angelegt und gemanagt werden können.

Synapse Data Engineering (Preview):

Bietet Cloud-Data-Warehousing und SQL-Analysen in einem einzigen Workspace. Integriert werden können relationale als auch nicht-relationaler Daten. Hierfür nutzt Synapse die MPP-Datenbanktechnologie (Massively Parallel Processing), die es ermöglicht, auch große analytische Workloads zu verarbeiten und ist mit Scala, Python, Java, R und Spark SQL kompatibel.

Synapse Data Science (Preview):

Bietet einen End-to-End-Workflow für zentralisiertes Data Science, um kollaborativ zusammenzuarbeiten und Modelle für maschinelles Lernen zu trainieren, einzusetzen und zu verwalten.

Synapse Data Warehousing (Preview):

Zentrales Data Warehouse der Fabrics Analytics Platform. Elastische SQL-Rechenleistung und Speicherung der Daten bei offenem Datenformat.

Synapse Real-Time Analytics (Preview):

Verarbeitung von Streaming-Daten aus IoT-Anwendungen, Telemetrie, Server-Logs und semistrukturierten Daten in Echtzeit.

Power BI:

Vollständige Integration des BI- und Dashboarding Tools Power BI.

Data Activator (Angekündigt):

Erkennung und Überwachung von Daten in Echtzeit. Monitoring und Benachrichtigung von Abweichungen vom Datenschema über Alerts und Error Logging.

Weitere Informationen zu Microsoft Fabrics sowie der Möglichkeit zur Anmeldung zu einer kostenlosen Testversion finden Sie hier.

Quelle: azure.microsoft.com

12. Digitale Analyse mit der Piwik Pro Analytics Suite

mohrstade Whitepaper

Piwik Pro ist eine Analytics Suite, bei der das Thema Datenschutz einen besonders hohen Stellenwert einnimmt. Die Speicherung und Verarbeitung der Daten ist transparent gestaltet und findet vollständig innerhalb der Europäischen Union statt. Durch den zunehmenden datenschutzrechtlichen Druck stößt Piwik Pro bei vielen Unternehmen auf zunehmendes Interesse. Für die Nutzung der Analytics Suite werden unterschiedliche Pläne bereitgestellt, die sich in ihrem Funktionsumfang klar unterscheiden.

In unserem aktuellen Whitepaper wird die Piwik Pro Analytics Suite mit ihren Plänen und Funktionen in einen Vergleich gestellt und die wichtigsten Unterschiede zu bekannten Analytics-Lösungen wie Google Analytics 4 (GA4) aufgezeigt, um eine Entscheidungsgrundlage für oder gegen einen Wechsel in die Piwik Pro Analytics Suite zu bieten.

Digitale Analyse mit der Piwik Pro Analytics Suite