Inhalt

- Aufruf von Cloud Functions oder Cloud Run in BigQuery

- Neue Dimensionen und Metriken für GA4

- Custom Dimensions/Metrics als primäre Dimension nutzen

- Preview der Snowplow BDP Cloud

- Snowplow Open Source BigQuery Quick Start Guide

- Profile Sync und Reverse ETL

- GA4 Data API Limits für Looker Studio

- Committed Use Discounts für GCP User

- Safari Technology Preview 157

- mohrstade Whitepaper | Richtiger Einsatz der Google Consent Mode API

Liebe Leser,

die Einführung eines Quota Limits für die Datenverbindung von GA4 und Looker Studio hat nicht nur überrascht, sondern stellt auch viele User vor Probleme. Doch laut Google ist bereits Besserung in Sicht. Wichtige neue Features in anderen Tools erregen ebenfalls Aufmerksamkeit. Snowplow stellt mit der Behavioral Data Platform (BDP) ein Beta-Feature für ausgewählte Kunden zur Verfügung und Segment erweitert die CDP-Funktionalität mit Profile Sync und Reverse ETL.

Viel Spaß beim Lesen!

1. Aufruf von Cloud Functions oder Cloud Run in BigQuery

Bereits im Mai dieses Jahres wurden Remote Functions für BigQuery in einer ersten Preview zur Verfügung gestellt. Nun ist das neue Feature in vollem Umfang nutzbar.

Remote Functions ermöglichen es, Funktionen in anderen Sprachen als SQL und Javascript oder mit Bibliotheken und Diensten zu implementieren, die in den user defined functions (UDF) von BigQuery standardmäßig nicht unterstützt werden.

Eine Remote-UDF akzeptiert Spalten von BigQuery als Eingabe, führt mithilfe einer Cloud Function Aktionen durch und gibt das Ergebnis der Ausführung als Wert zurück. Typische Anwendungsfälle für Remote Functions sind:

Anonymisierung und Sicherheit:

Nutzung von Diensten für die Verschlüsselung und Tokenisierung von Daten aus der Google Cloud für externe Verschlüsselung und De-Identifizierung

Real-time APIs:

Erweiterung der Daten durch externen APIs (Bsp. Wetterdaten oder Geokodierung)

Code Migration:

Migration bestehender UDFs oder andere Funktionen, die in Node.js, Python, Go, Java, .NET, Ruby oder PHP geschrieben wurden

Data Science:

Aufruf von in Vertex AI oder anderen Plattformen für maschinelles Lernen gehosteten Modellen

Quelle: cloud.google.com/blog

2. Neue Dimensionen und Metriken für GA4

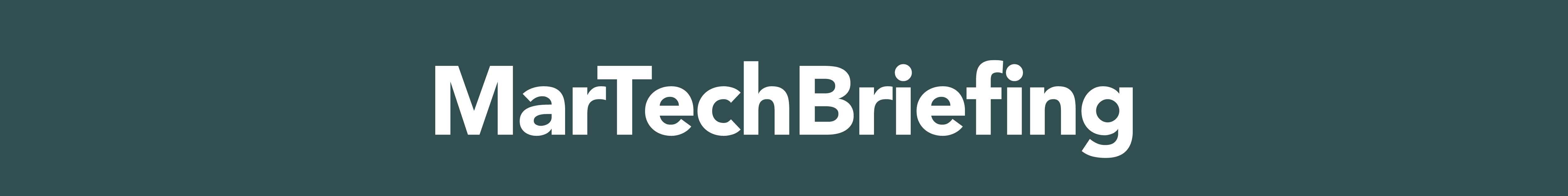

Seit Neuestem stehen weitere Datums- und Stundendimensionen in GA4 zur Verfügung, die in explorativen Analysen und in Berichten genutzt werden können. Somit lassen sich detaillierte Informationen zu einzelnen Zeitpunkten für Interaktionen im Betrachtungszeitraum beziehen.

Beispielsweise stehen mit dem Update nun N-th Ausprägungen der einzelnen Datums -und Stundendimensionen zur Verfügung, welche die Anzahl der Stunden, Tage oder Monate seit dem Beginn des angegebenen Datumsbereichs beschreiben.

Mit den neuen Dimensionen werden z. B. Retention- oder Kohortenanalysen nicht nur einfacher erstellt, sondern können auch flexibler den eigenen Bedürfnissen angepasst werden.

ABSTAND

ABSTAND

ABSTAND

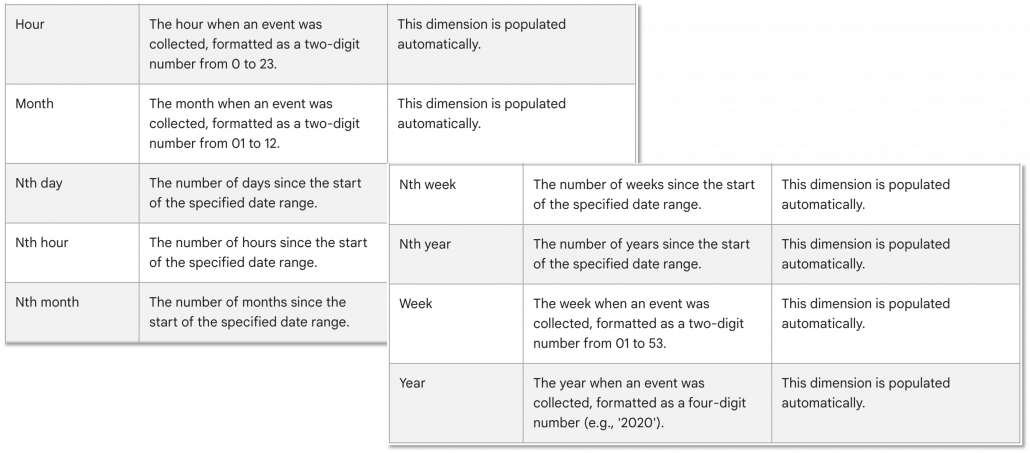

Zusätzlich werden in den Quota Limits bei der Erstellung von Custom Dimensions nun Limits für Item Scope Dimensions angezeigt. Diese wurden bisher noch nicht offiziell angekündigt, doch lässt die Einführung eines Dimension Limits vermuten, dass diese bald in GA4 verfügbar sein werden. Das Limit wurde bisher auf 25 Item Scope Dimensions pro Property festgelegt.

In den Explore und Standard Reportings stehen mit Views per Session und der Average Session Duration weitere Metriken zur Verfügung. Views per Session gibt die Anzahl der Screenviews (App) und Pageviews (Web) an, die ein Nutzer pro Sitzung generiert hat. Die Average Session Duration zeigt die durchschnittliche Dauer der Session eines Nutzers in Sekunden.

Quelle: support.google.com

ABSTAND

Quelle: analytics.google.com

3. Custom Dimensions/Metrics als primäre Dimension nutzen

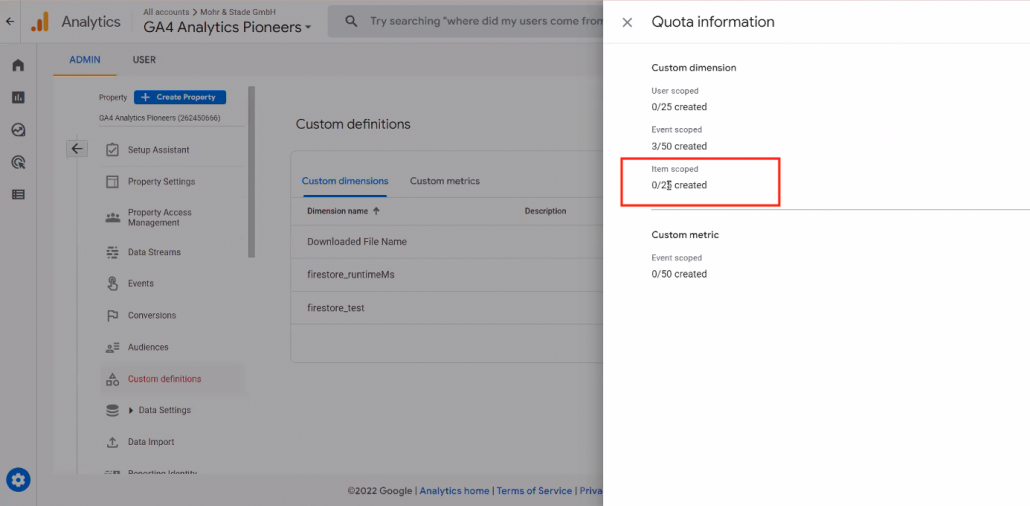

In benutzerdefinierten Berichten lassen sich ab sofort benutzerdefinierte Dimensionen und Metriken als primäre Dimensionen hinzufügen, was mehr Flexibilität und einen höheren Individualisierungsgrad der Reportings im GA4 Interface ermöglicht.

Zudem wurden die Auswahlmöglichkeiten für Dimensionen und Metriken im Report Builder aktualisiert, um eine einfachere Navigation in der Auswahl von Dimensionen und Metriken zu ermöglichen.

Quelle: analytics.google.com

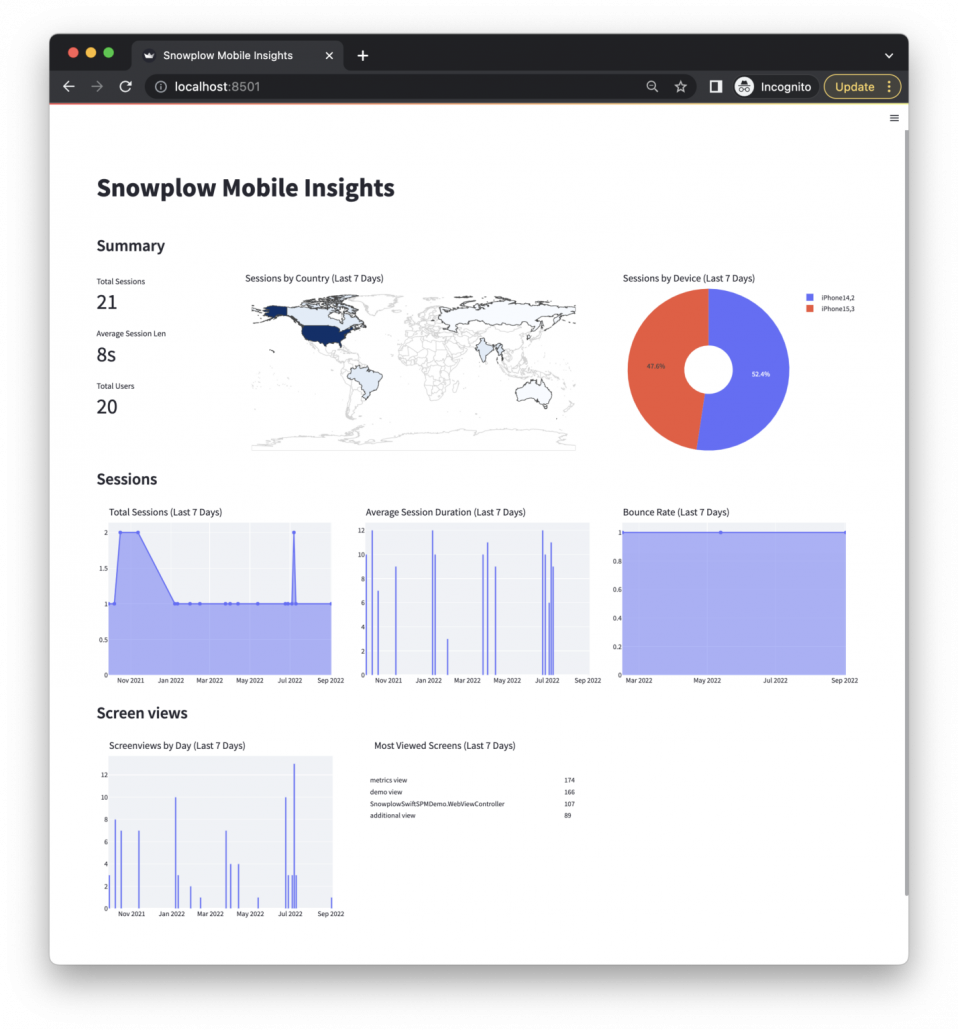

4. Preview der Snowplow BDP Cloud

ABSTAND

Mit der BDP Cloud will Snowplow das Portfolio an Leistungen seiner Behavioral Data Platform (BDP) erweitern. Die BDP Cloud bietet dabei die Flexibilität der Open Source Pipeline von Snowplow ohne die technischen Anforderungen des Hostings und der Wartung der Pipeline in der eigenen Cloud-Umgebungen.

Snowplow erhofft sich, durch die BDP Cloud auch kleinere Unternehmen für ihr Enterprise-Angebot gewinnen zu können, welche andernfalls den Wartungsaufwand einer eigenen Data Pipeline mit internen Ressourcen nicht decken oder auch den vollen Preis der BDP nicht zahlen könnten.

Die BDP Cloud wird vor Ende 2022 für eine ausgewählte Anzahl von Kunden als Closed-Beta verfügbar sein. Die vollständige Einführung erfolgt im ersten Quartal 2023. Bei Interesse an der BDP Cloud können Sie sich hier für die Closed-Beta eintragen.

ABSTAND

Quelle: snowplow.io/blog/

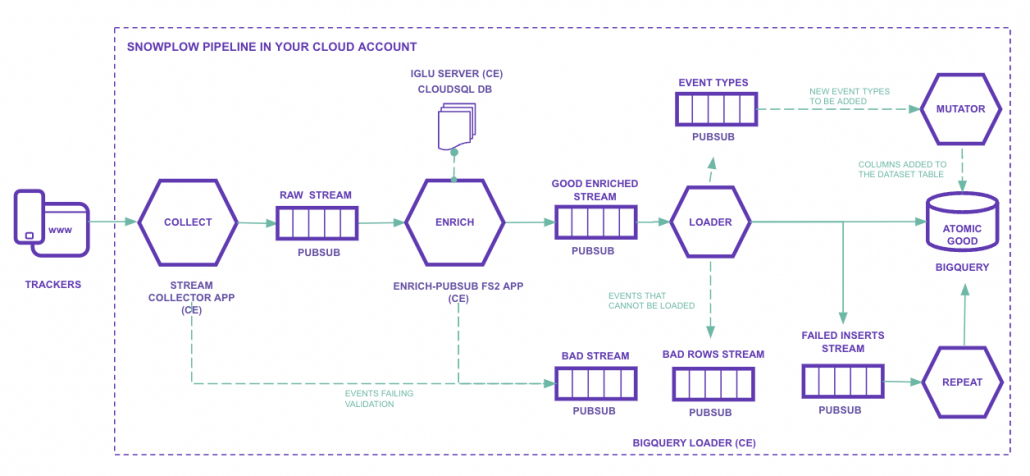

5. Snowplow Open Source BigQuery Quick Start Guide

ABSTAND

Vor Kurzem hat Snowplow den GCP Quick Starter Guide für seine Open Source Data Pipeline um BigQuery ergänzt. Bisher ließ sich die OS Pipeline in der GCP lediglich mit Postgres zu BigQuery oder einer anderen Data Warehouse-Lösung überführen, was die Einrichtung der Pipeline komplexer machte.

Unter dem Schirm des Snowplow BigQuery Loader stellt Snowplow nun eine Reihe von Anwendungen zur Verfügung, mit welchen Daten in BigQuery geladen werden können:

BigQuery Loader

ist eine App-Engine Instanz, die den Enriched Stream konsumiert und die Daten in BigQuery überträgt. Den Loader gibt es in zwei Varianten (Loader und StreamLoader).

BigQuery Mutator

ist für die automatische Aktualisierung des Tables zuständig, sobald ein neues Custom Event oder eine neue Entity hinzufügt wurde.

BigQuery Repeater

ist für die Behandlung fehlgeschlagener Inserts zuständig. Dieser liest Events aus einem speziellen Pub/Sub-Topic zum Thema „failedInserts“ aus und versucht anschließend, diese erneut in BigQuery zu überführen, um eine Verzögerung bei der Tabellenaktualisierung zu verhindern.

ABSTAND

Quelle: docs.snowplow.io

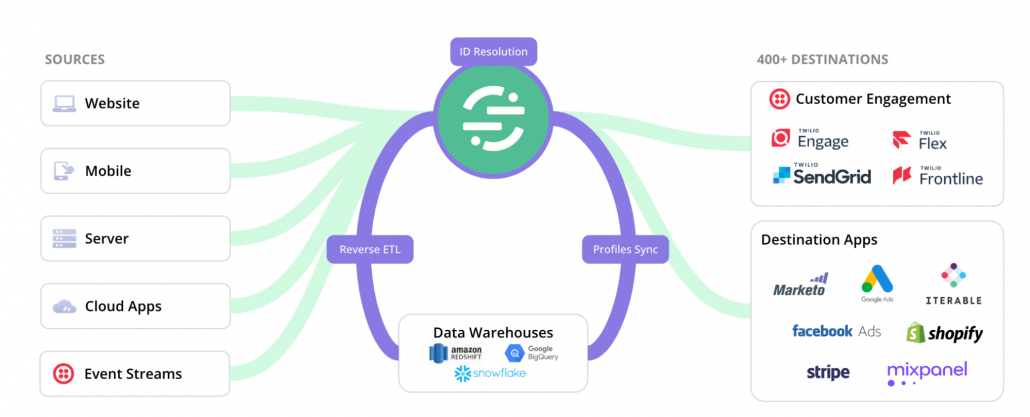

6. Profile Sync und Reverse ETL

Neue Features für die Segment CDP

ABSTAND

Anfang Dezember stellt Twilio den Nutzern seiner Segment CDP mit Profiles Sync und Reverse ETL zwei neue Funktionen in einer ersten Public Beta-Version zur Verfügung.

Mit der Hilfe von Profiles Sync lassen sich die in Segment erstellten Nutzerprofile in das eigene Data Warehouse übertragen bzw. synchronisieren. Über die Segment Identitiy Resolution können somit einheitliche Nutzerprofile gebildet werden, die dann anschließend als Datengrundlage für das weitere Data Modeling im Data Warehouse verwendet werden können. Dabei lassen sich auch bereits bestehende Kundendatensätze im Data Warehouse verbinden und synchronisieren.

Über das Pipeline Management Tool Reverse ETL bietet Segment anschließend die Möglichkeit, die modellierten Kundendaten downstream an nachgelagerte Systeme und Tools zu überführen. Mit den beiden Funktionen möchte Segment sein Toolkit für die Profilanreicherung und -verschiebung außerhalb der CDP erweitern, um das Arbeiten mit der Plattform im individuellen Cloud-Ökosystem zu verbessern.

Profiles Sync wird für alle Segment Engage-Kunden ohne zusätzliche Kosten verfügbar sein. Reverse ETL steht allen Segment Connections-Kunden auf allen Ebenen zur Verfügung. Wer an der Beta-Phase teilnehmen möchte, kann hier eine Anfrage für eine Einladung an Segment stellen.

ABSTAND

Quelle: segment.com/blog

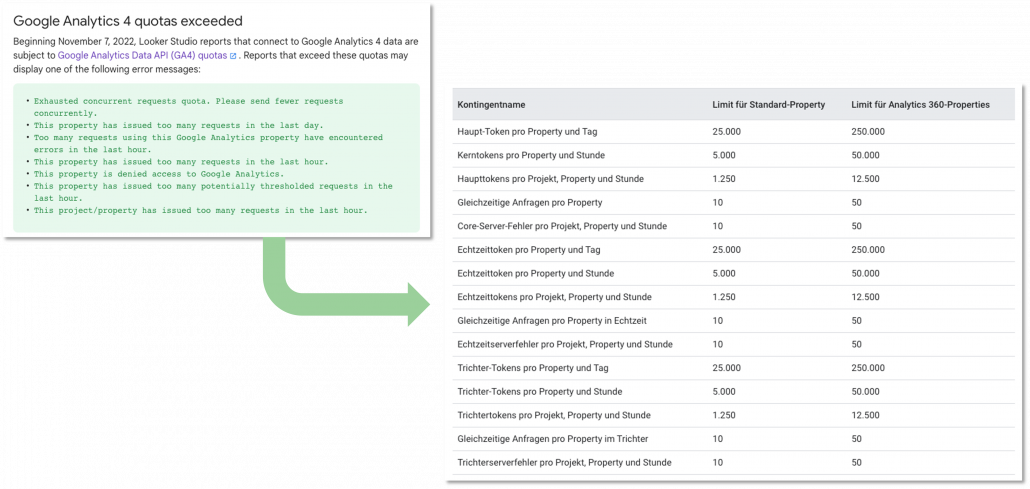

7. GA4 Data API Limits für Looker Studio

Seit Anfang November unterliegen Looker Studio Reports, die mit Google Analytics 4-Daten verbunden sind, den neuen Limits der GA4 Data API.

Für Standard-GA4-Properties können beispielsweise nur noch zeitgleich 10 Requests an die Data API gestellt werden, wodurch Dashboards mit komplexeren Data Blends relativ schnell an ihre Grenzen stoßen. Auch wurde ein Limit fürs Events pro Nutzer und Tag (für App-Data Streams) eingeführt, welches sich in Standard-GA4-Properties auf 500 Events und in 360-Properties auf 2000 beschränkt.

Der von Google bis dato vorgeschlagene Lösungsansatz im Umgang mit den neuen Limits ist umso ernüchternder. In seiner API-Dokumentation schlägt Google beispielsweise vor, die Zugriffe auf die Looker Studio Dashboards zu reduzieren, indem Reports mit weniger Personen geteilt werden, oder weniger Charts pro Dashboard zu verwenden, die Anfragen an eine GA4-Datenquelle stellen.

Im offiziellen Google Support-Forum meldete sich bereits ein Google-Mitarbeiter im Rahmen einer Diskussion zu Wort und versicherte, dass man bereits an einer Lösung arbeite.

Das kommende Update soll u. a. die Art und Weise ändern, wie Looker Studio Abfragen wiederholt, um die Auswirkungen der Limits für parallele Abfragen pro GA4-Property zu kompensieren und eine Anzeige über verbrauchte Token und die verbleibende Menge an Tokens beinhalten. Zur Stellungnahme geht es hier.

Quelle: developers.google.com

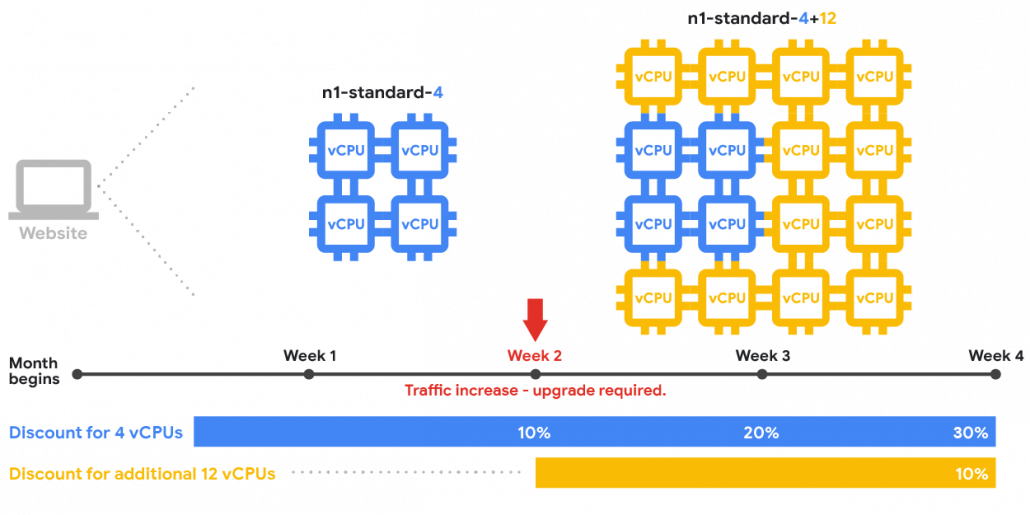

8. Committed Use Discounts für GCP User

Die Google Cloud bietet Rabatte, sog. Committed Use Discounts (CUD), für Nutzer an, die sich für einen bestimmten Zeitraum (1-3 Jahre) verpflichten, ein Minimum an Ressourcen innerhalb der Google Cloud zu nutzen. Die Rabatte sind flexibel einsetzbar, decken eine Vielzahl von Ressourcen ab und eignen sich ideal für Workloads mit vorhersehbarem Ressourcenbedarf.

Unterschieden wird zwischen Ausgabenbasierten Zusicherungen, bei denen die Nutzung in US-Dollar pro Stunde entsprechend der On-Demand-Ausgaben gemessen wird, und Ressourcenbasierten Zusicherungen, bei denen ein Rabatt gewährleistet wird, wenn eine Mindestmenge an Compute Engine-Ressourcen genutzt wurde. Der Rabatt gilt für vCPUs, Arbeitsspeicher, GPUs und lokale SSDs. Committed Use Discounts können für GCP Services wie Cloud Run- oder Compute Engine-Instanzen genutzt werden und somit laufende Kosten der VM-Instanzen erheblich verringern.

CUDs lassen sich im Google Cloud Interface unter Cloud Billing > Zusicherungen einrichten. Weitere Informationen zu Preismodalitäten finden sich hier.

Quelle: cloud.google.com/compute/docs/sustained-use-discounts

9. Safari Technology Preview 157

Safari hat eine neue Version seiner Technology Preview (Version 157) veröffentlicht. Neben standardmäßigen Fehlerbehebungen und Leistungsverbesserungen für Web Inspector, CSS, Rendering, JavaScript, Web-APIs und vielem mehr, gibt es auch ein neues Privacy Update mit weniger erfreulichen Auswirkungen auf die digitale Analyse und das digitale Marketing.

So gibt der Browser in seiner Release Note unter dem Punkt „Privacy“ bekannt, die Lebensdauer von Cookies in der Kommunikation mit Third Party IP-Adressen auf 7 Tage zu begrenzen.

Die Umstellung der Logik für die Begrenzung der Lebensdauer von Cookies geht über die bisher bekannten Einschränkungen von Safari und anderer relevanten Browser hinaus. Somit ist das Senden eines Cookies per Server nicht mehr ausreichend, denn auch die IP-Adresse des Servers muss angepasst werden. Der Aufwand hierfür ist gegebenenfalls sehr hoch, sodass eine Abwägung des Impacts und der Kosten durch die Verlängerung eines Cookies über 7 Tage hinaus sinnvoll ist.

10. Richtiger Einsatz der Google Consent Mode API

Ein Ansatz für (mehr) Datenschutz und Transparenz

mohrstade Whitepaper

Der Google Consent Mode soll mehr Flexibilität in der Verwaltung von Cookie-Einwilligungen in Verbindung mit Google-Produkten wie Google Analytics oder Google Ads bieten. Was auf den ersten Blick nach einer datenschutzfreundlichen Lösung für den restriktiven europäischen Raum klingt, wurde in den vergangenen Monaten von einigen Datenschützern in der Digital Analytics Szene kontrovers diskutiert. Gründe dafür sind die fehlende Transparenz des Conversion Modeling und der Datentransfer zwischen Browser (Client) und Google-Server.

In seinen Standardeinstellungen verfehlt das Konzept des Google Consent Mode seinen eigentlichen Zweck zur Sicherstellung des Datenschutzes nach europäischem Recht. In unserem neuen Whitepaper stellen wir Lösungsansätze für ein transparentes Conversion Modeling sowie einen anonymisierten Datentransfer der Conversions vor.

Richtiger Einsatz der Google Consent Mode API