Inhalt

Liebe Kunden,

Data Driven Attribution ist seit Jahren eine Herausforderung. Mit Google Analytics 4 wird der Einstieg zumindest leichter, da Data Driven Attribution in GA4 ein Standardfeature geworden ist und ebenso für alle Reports genutzt werden kann.

In unserem neuen Whitepaper beschäftigen wir uns mit Customer Data Platforms und wie Wetterdaten dort zentralisiert angebunden werden können.

Viel Spaß beim Lesen!

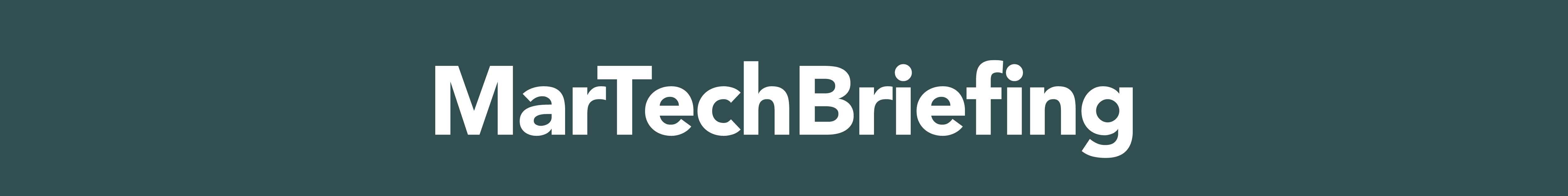

Default Data Driven Attribution in GA4

Seit Ende des Monats wird das DDA-Modell offiziell als Default Modell in allen GA4-Properties ausgewiesen. Das DDA-Modell und alle regelbasierten Attributionsmodelle sind nun auf Property Ebene unter Admin>Attributionseinstellungen hinzugefügt.

Zum ersten Mal in der Historie von Google Analytics lässt sich ein anderes Default Attributionsmodell als Last Click Non-Direct in den Standard-Reports verwenden. Data Driven Attribution stand bisher lediglich Enterprise-Kunden zur Verfügung und ist jetzt auch in der Standardversion von Google Analytics für jedermann nutzbar. Für die Aktivierung bzw. Änderung der Einstellung benötigen User die Rolle „Editor“ Sie gilt für die Metriken Total Conversions, Total Revenue, Total Ad Revenue und Purchase Revenue in allen Berichten, in denen ereignisbezogene Traffic-Dimensionen verwendet werden können (z. B. Campaign, Source, Medium).

Das DDA-Modell basiert auf dem Ansatz des maschinellen Lernens, bei dem Conversion Rates über die User Journeys sowie über Channels hinweg miteinander verglichen werden. Ziel ist die Berechnung des Wertbeitrags zur Conversion jedes Kanals in der User Journey. Vor der Nutzung des Modells empfehlen wir ein Vergleich des Modells mit anderen in Google Analytics 4 verfügbaren Modell über das Model-Comparison Tool.

Quelle: support.google.com

JSON Datentyp für BigQuery Standard-SQL

BigQuery Standard-SQL unterstützt jetzt auch den JSON-Datentyp zum Speichern von JSON-Daten. Unter dessen Verwendung lassen sich nun auch semistrukturierte JSON-Daten in BigQuery integrieren, ohne im Voraus ein Schema für diese bereitzustellen.

Daten, die nicht immer den festgelegten Schemas und Datentypen entsprechen, können somit einfach gespeichert und abgefragt werden. Durch die Aufnahme von JSON-Daten als eigenen Datentyp kann BigQuery somit jedes JSON-Feld einzeln codieren und verarbeiten. Die Werte der Felder und Array-Elemente lassen sich anschließend innerhalb der JSON-Daten mit dem Operator für den Feldzugriff abfragen, was JSON-Abfragen einfach und kostengünstig macht.

Laden von Google Scripts über den Server-Side GTM

Seit Neuestem ermöglicht das Server-Side Tagging des Google Tag Managers Google Scripts (z. B. gtm.js/gtag.js) direkt über den eigenen GTM Server zu laden, anstatt über die Google Analytics Server. Somit kann die direkte Anfrage an einen Google Server vom Client aus unterbunden und über den Google Tag Manager Server geroutet werden.

Durch das Zwischenschalten des Servers werden keine Daten des Clients, wie bspw. die IP-Adresse, an den empfangenden Server gesendet.

Ablöse für FLoC (?)

Google stellt die Topics API für seine Privacy Sandbox vor

Letzte Woche stellte Google auf seinem Blog offiziell die Einführung seiner neuen Topics-API vor, um die rechtlich stark umstrittene FLoC-API (Federated Learning of Cohorts) in der Privacy Sandbox zu ersetzen.

Anstatt Nutzer verschiedenen interessenbasierten Kohorten zuzuordnen, werden diese auf der Grundlage ihres jüngsten Surfverhaltens mit einigen „Themen von Interesse“ in Verbindung gebracht.

Diese Themen werden anschließend mit den teilnehmenden Websites und den auf diesen Websites betriebenen Werbeplattformen geteilt und können zu jeder Zeit von dem Nutzer (Browser) selbst eingesehen, geändert oder vollständig deaktiviert werden. Dies ermöglicht eine interessenbasierte Ausrichtung, ohne so viele Informationen zur Identifizierung des Nutzers preiszugeben wie bei FLoC.

Bis zum Ende des ersten Quartals 2022 wird eine Testversion der Topics-API für Entwickler in Chrome eingeführt. Insgesamt scheint die Topics-API generischer zu sein als FLoC. Im Vergleich zu Cookies will Google Topics für die Nutzer transparenter gestalten.

Quelle: blog.google.com

Google Client-Id und Cookie-Werte mit Tealium IQ auslesen

mohrstade MarTechSnack

Viele Tools speichern Informationen, die im Tag Management benötigt werden, in Cookies. Darunter Unique Identifier und Testvarianten aus A/B-Testing Tools, die als Join-Keys verwendet werden. In unserem aktuellen MarTechSnack zeigt uns Marcus anhand der Google Client-Id, wie wir diese Informationen über Tealium IQ auslesen und in dem Universal Data Object, dem Tealium dataLayer, wieder zur Verfügung stellen können, um diese anschließend an die gewünschten Tools weiterzuleiten.

Google Client-Id und Cookie-Werte mit Tealium IQ auslesen | MarTechSnack #9

Zentralisierung von Wetterdaten in Tealium AudienceStream™

Eine Zusammenarbeit zwischen mohrstade, Tealium und METEONOMIQS

Die Anreicherung von Nutzerdaten durch standortspezifische Wetter-Informationen ist ein bewährtes Mittel für die personalisierte Aussteuerung von Marketingmaßnahmen. Das Einbinden von Wetterdaten wird dabei mittlerweile von einigen Tools standardmäßig unterstützt. Jedoch kann sich die Granularität der Wetter-Informationen von Tool zu Tool unterscheiden und/oder starke Qualitätsunterschiede aufweisen. Bei Nutzung einer Customer Data Platform ist es daher von Vorteil, Wetterdaten zentral zu ergänzen, anstatt toolseitig zu konsolidieren, um ihre Qualität auch auf einer quantitativen Ebene zu gewährleisten.

Als Ergebnis aus der Zusammenarbeit von mohrstade, Tealium und METEONOMIQS entstand ein technischer Leitfaden für eine zentralisierte Integration von Wetterdaten für einzelne Customer Data Profiles in der Tealium AudienceStream™CDP, den wir Ihnen in Form unseres neuen Whitepapers präsentieren dürfen.

Zentralisierung von Wetterdaten in Tealium AudienceStream™