Inhalt

Liebe Leser,

die Orchestrierung von Daten-Pipelines ist nicht nur im Umgang mit Marketingdaten wichtig. Für diese Aufgabe wird häufig das Tool dbt eingesetzt. In unserem monatlichen Whitepaper widmen wir uns der Dokumentation und Transformation von Daten mit dbt Core in der Cloud. Obwohl für die Google Cloud Platform mit Dataform ein integriertes Cloud-Produkt für BigQuery zur Verfügung steht, lohnt es sich, einen Blick auf dbt zu werfen. Auch beschäftigen wir uns wieder mit den GA4 Updates des Monats Februar sowie mit einigen Neuerungen in Google Ads und der Google Search Console.

Viel Spaß beim Lesen!

1. Azure Blob für BQ Data Transfer Service

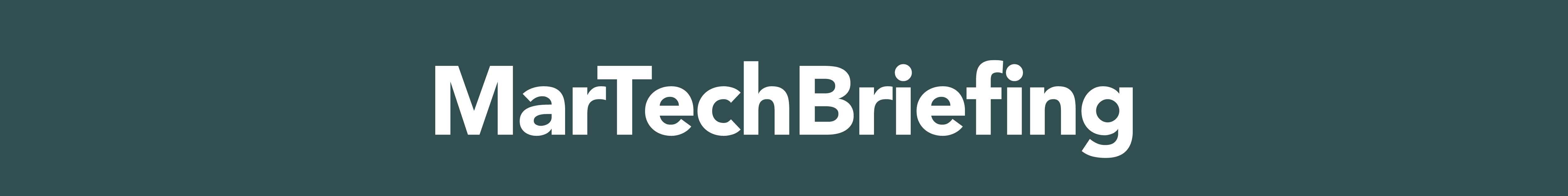

Der BigQuery Data Transfer Service kann jetzt auch Daten aus Azure Blob Storage zu BigQuery übertragen.

Für die Einrichtung in BigQuery wird lediglich der Name des Blob-Storage-Kontos, der Containername sowie ein Shared-Access-Signature-Token (SAS) für Azure benötigt, das Lesezugriff auf die Datenquelle gewährt. Informationen zum Erstellen eines SAS-Tokens finden Sie hier. Das Feld für den Datenpfad ist optional und wird zum Abgleichen gängiger Objektpräfixe und Dateiendungen verwendet. Wenn kein spezifischer Datenpfad angegeben wird, werden alle Dateien im Container übertragen.

Alle BigQuery-Kontingente und Limits für Ladejobs gelten ebenfalls für wiederkehrende Blob Storage Transfers. Das Ladelimit pro Job beträgt 15 Terabyte und ist auf 10.000 Dateien begrenzt.

Quelle: comsole.cloud.google.com

2. Änderungen im Targeting des Google Display Networks (GDN)

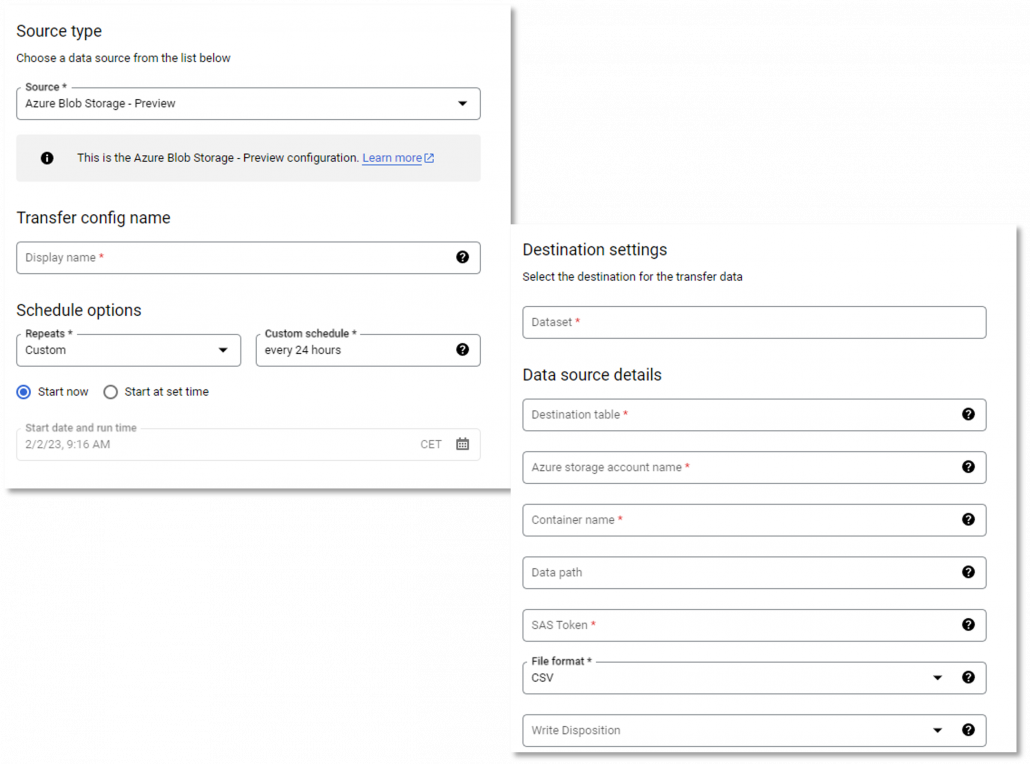

Anfang März nimmt Google drastische Änderungen an den Content-Targeting-Optionen in Google Ads vor. Dabei wird primär die Ausrichtungslogik von Display-Anzeigen geändert. Bisher konnten Display-Anzeigen auf bestimmte Websites ausgerichtet werden UND sich zusätzlich auf bestimmte Themen beziehen. Jetzt wird aus dem „UND“ ein „ODER“. Anstatt die genau beabsichtigte Zielgruppe zu erreichen, wird somit sie ein viel breiteres und unspezifischeres Publikum targetiert. Ergo, schlechteres Targeting bei steigenden Werbeeinnahmen für Google. Die Änderungen werden automatisch auf laufende Kampagnen angewendet und es gibt keine Möglichkeit, dies zu vermeiden.

Quelle: google.com (Mailing)

3. Neue Features im GA4 Interface

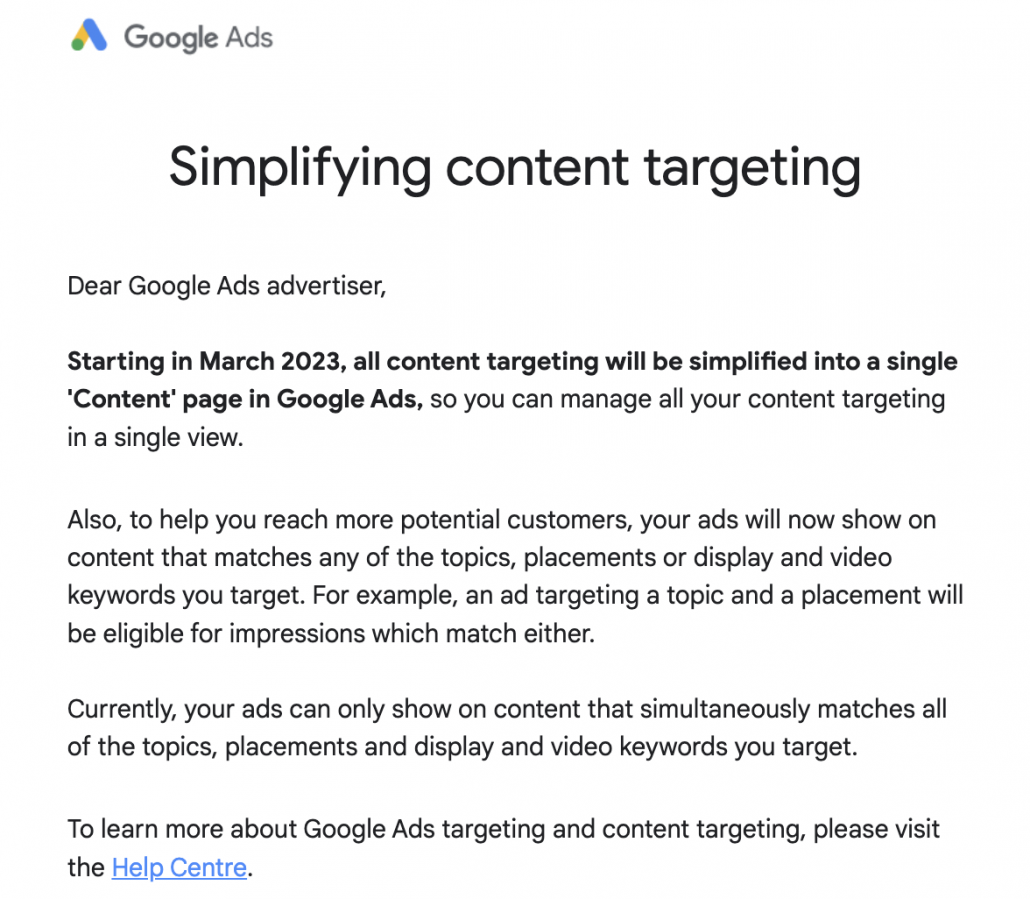

Vergangenen Monat wurden kleinere Features für das Google Analytics 4 Interface veröffentlicht, um die Reporting Experience größerer Datenmengen zu verbessern, darunter folgende:

Data Quality Icon auf Karten-Ebene

Bisher wurde das Data Quality Icon oben im Snapshot-Bericht für die Berichterstattung und in den Übersichtsberichten angezeigt. Ab sofort wird das Data Quality Icon nun auch für einzelne Karten angezeigt, sodass ersichtlicher wird, welche Meldungen für die einzelnen Karten in einem Bericht gelten. Zusätzlich wird eine „other row“-Message angezeigt, wenn ein Bericht von Kardinalitätsgrenzen betroffen ist. In dieser neuen Meldung stehen Möglichkeiten zur Verfügung, die Kardinalität des Reports zu verringern oder zu beseitigen.

Neue Sampling Controls für 360 Properties

Mit den neuen Sampling Controls lässt sich der Grad der Präzision und Geschwindigkeit des Samplings anpassen. Zur Verfügung stehen:

More detailed results:

verwendet die maximal mögliche Stichprobengröße, um Ergebnisse zu liefern, die den gesamten Datensatz so genau wie möglich widerspiegeln.

Faster results:

verwendet einen kleineren Stichprobenumfang, um schnellere Ergebnisse zu erzielen (Default Option).

Quelle: analytics.google.com

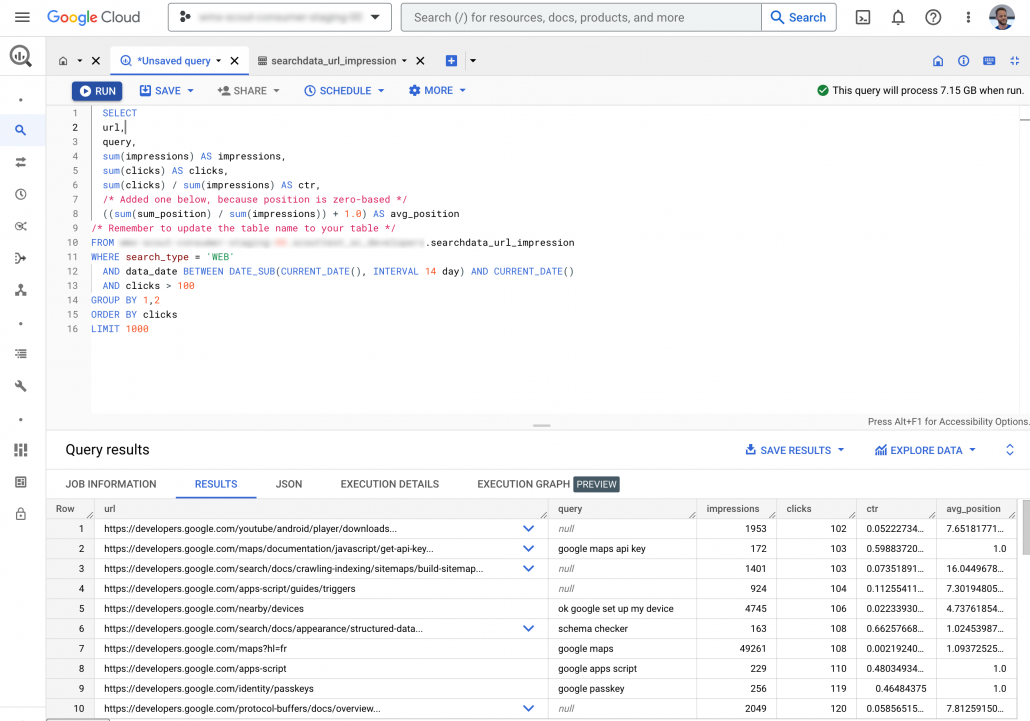

4. Bulk Export für Search-Console-Daten

Mit dem Bulk Data Export veröffentlichte Google Ende Februar ein neues Feature für die Google Search Console. Das Feature ermöglicht es, Rohdaten aus der Search Console zu BigQuery für die Datenmodellierung und Datenanalyse zu exportieren.

Die Daten werden dabei nach Property, URL und einer Aufzeichnung der tagesaktuellen Daten zusammengefasst und in folgende drei Tabellen zur Verfügung gestellt:

Searchdata_site_impression:

enthält aus der Property aggregierte Daten zu den Dimensionen query, country, type, und device.

Searchdata_url_impression:

enthält nach URL aggregierte Daten, die eine detailliertere Ansicht von queries und search results bieten.

ExportLog:

bietet eine Übersicht über die Daten, die am ausgewählten Tag erfasst wurden.

Die Funktion ist bereits für kleine und mittlere Websites verfügbar, die über das Search Console UI, den Looker Studio Connector oder die Search Analytics API Datenzugriff haben. Gerade für große Websites mit zahlreichen Seiten oder Traffic aus Zehntausenden von Suchanfragen pro Tag liefert der Bulk Data Export einen erheblichen Mehrwert für die Datenanalyse.

Quelle: developers.google.com

5. Google released Ads Privacy Hub

Im Februar hat Google seinen Ads Privacy Hub veröffentlicht. Der Ads Privacy Hub ist eine Website, auf der Informationen zu aktuellen Änderungen im Datenschutz und deren Auswirkungen auf die Anzeigenleistung von Google-Produkten zur Verfügung gestellt werden. Google selbst betitelt den Ads Privacy Hub als neue „Source of truth“ für neue Technologien und Änderungen im Werbenetzwerk. Zurzeit ist der Ads Privacy Hub in 16 Ländern verfügbar, darunter auch Deutschland, die Vereinigten Staaten, Großbritannien, Italien, Frankreich und Spanien.

Auf der Website wird von Google zusätzlich der Ads Privacy Planner angeboten: eine kurze Survey, um einen „maßgeschneiderten datenschutzfreundlichen Analyseplan“ zu erhalten. Der Ads Privacy Planner ist aktuell in vier Ländern verfügbar (Vereinigte Staaten, Vereinigtes Königreich, Deutschland, Thailand) und wird in der zweiten Jahreshälfte 2023 global ausgerollt.

Zum Ads Privacy Hub geht es hier.

Quelle: support.google.com

6. Dokumentation und Transformation von Daten mit dbt Core in der Cloud

mohrstade Whitepaper

dbt (data build tool) ist ein Open Source Command Line Tool, das primär das Testing, die Dokumentation sowie die Transformation von Daten im Data Warehouse unterstützt. Das Tool soll Data Teams die Arbeit mit Daten erleichtern, indem es einen konsistenten und standardisierten Ansatz für die Datentransformation und -analyse bietet. Mit dbt können Nutzer Datenmodelle mithilfe von SQL definieren und anhand dieser Modelle optimierten SQL-Code erzeugen, der gegen ein Data Warehouse ausgeführt werden kann.

In unserem neuesten Whitepaper zeigen wir, welche Probleme dbt im Transformationsprozess und Management einer Modern Data Pipeline löst, welche Kernfunktionalitäten das Tool bietet und wann ein Einsatz sinnvoll ist.

Dokumentation und Transformation von Daten mit dbt Core in der Cloud